阿尼尔·塞斯——有意识人工智能的神话

2026-01-22 22:25:29 · chineseheadlinenews.com · 来源: 博古睿研究院

美国洛杉矶时间2026年1月13日,博古睿研究院宣布了2025年博古睿论文奖公布获奖名单,三位得主分别为中文区的黄鑫、刘骁奔,以及英文区的阿尼尔·塞斯(Anil Seth)。

本文选取了第二届博古睿论文奖的英文获奖文章,由萨塞克斯大学(University of Sussex)认知与计算神经科学教授、意识科学研究中心主任阿尼尔·塞斯撰写,由博古睿研究院授权“神经现实”转载。

几百年来,人们梦想自己能够扮演上帝的角色,去创造真实人类的人工版本。每一次突破性的新技术浪潮的到来,都会一次次引燃这个梦想,而这一次人工智能(AI)带来的浪潮尤其巨大。至少从某些方面来讲,目前我们周围的AI系统,已经算得上具有了智能。我们可以肯定,它们还会变得越来越智能。但问题是,它们具有,或可能具有意识吗?

但是勒莫因提出的问题并未消失。因为一个人违反了保密政策而解雇他,不意味着他说的就是错的。随着AI技术不断提升,机器意识这一问题浮现的频率越来越高。该领域里最前卫的思想者大卫·查默斯(David Chalmers)认为,有意识的机器在不太远的将来就可能出现(文献1)。AI先驱、诺贝尔奖获得者杰弗里·辛顿(Geoffrey Hinton)甚至认为,这已经实现了。22024年末,一群知名学者发表了一篇广为流传的文章,认为有必要严肃对待AI系统的福利问题(文献2)。对于包括AI专家与神经科学家在内的很多人而言,现在的问题在于机器意识何时出现,而非能否出现。

认为AI有意识的几个诱因

因此,一个人工智能系统的好坏,就取决于其完成某种智能行为的能力,尽管这里的行为不仅限于类人的形式。相比之下,通用人工智能(AGI)的概念里,确实明确了以整体的人为参考对象。AGI的目标在于,完全匹配甚至超越人类的认知能力(文献3)。(还有另一个概念——超级人工智能(ASI),即当AI自身进化到一种超出我们的理解并且失控时产生的现象。这种超级智能往往在我们各类未来世界中,伴随着更为严峻的存在境况而横空出世。)

将这些偏见放在一起考虑,我们要解释的事情就不奇怪了:当事物展现出我们认为具有典型人类特征的能力(比如智能)的时候,我们会自然而然将我们觉得独属于人类的其他典型特质,比如理解、心灵与意识,也投射到那些事物上。

图1: 肉桂面包里的特蕾莎修女

意识与计算

“有意识的人工智能”这个想法,预设了意识是一种计算或“信息处理”。更具体而言,它预设了只要提供某种恰当类型的计算,就足以让意识从中产生。这一预设被哲学家称为计算功能主义(computational functionalism,文献6)。该预设处于理论非常底层的位置,以至于要意识到这个预设本身就很难。但这个预设就是计算功能主义,事实就是如此。如果如我所认为的那样,这个预设错了,那么真正的人工意识根本无从谈起,至少对于我们熟悉的AI形态而言就是这样。

要挑战计算功能主义,就要深入讨论什么是“计算”,并理解对于一个计算机或大脑这样的物理系统而言,“做计算”到底是什么意思。根据那个预设,计算(至少是我们熟悉的那种计算)对于意识是充分的。接下来,我将概述四种相关的直觉,来动摇上述预设。

直觉1:大脑不是计算机

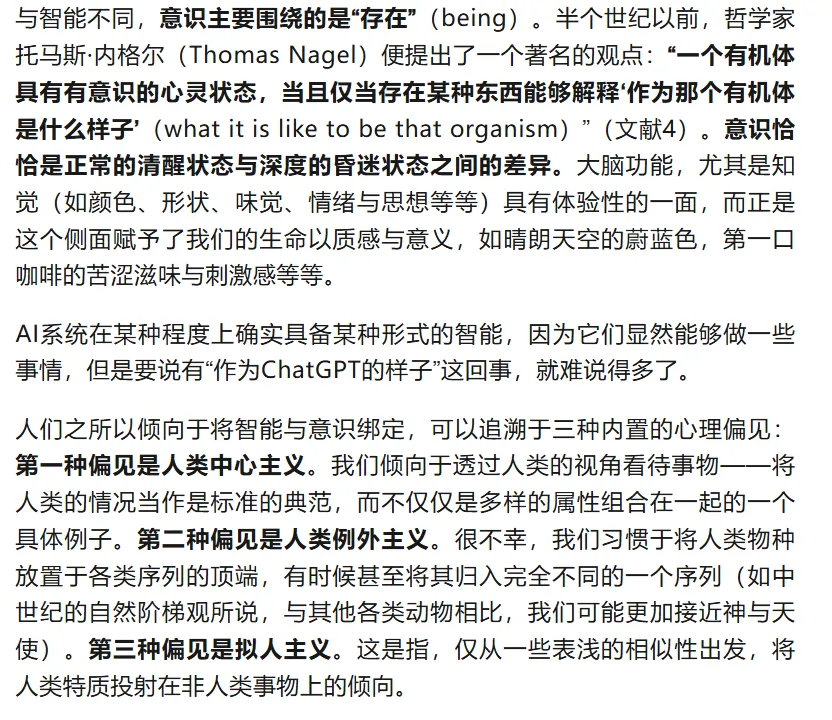

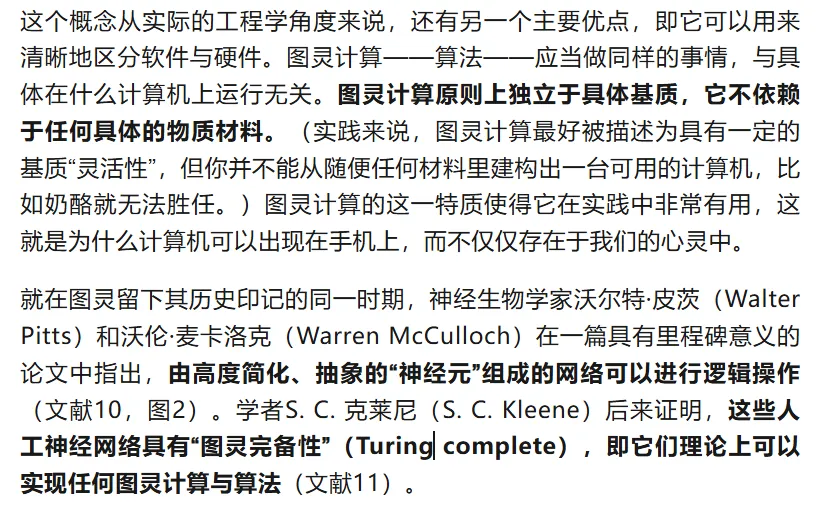

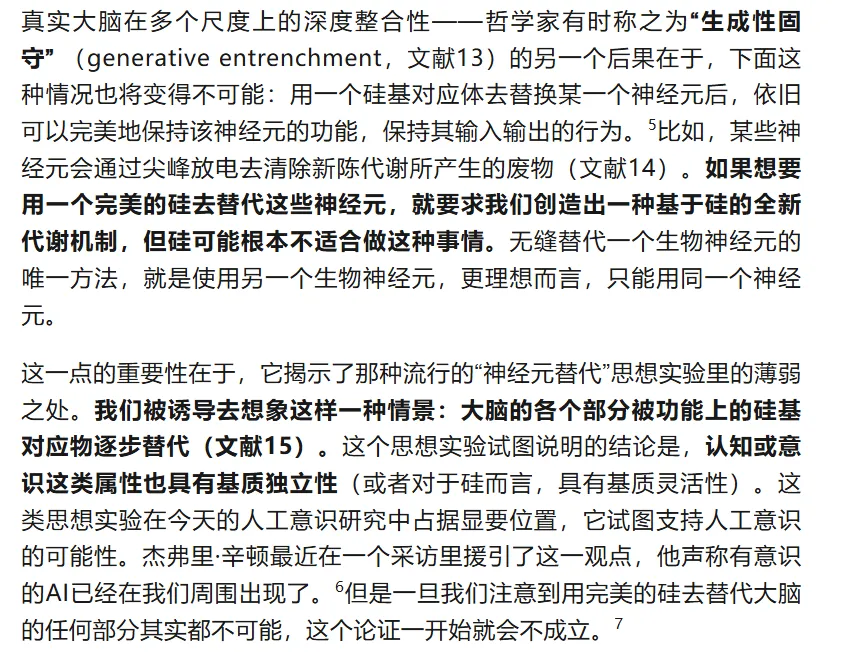

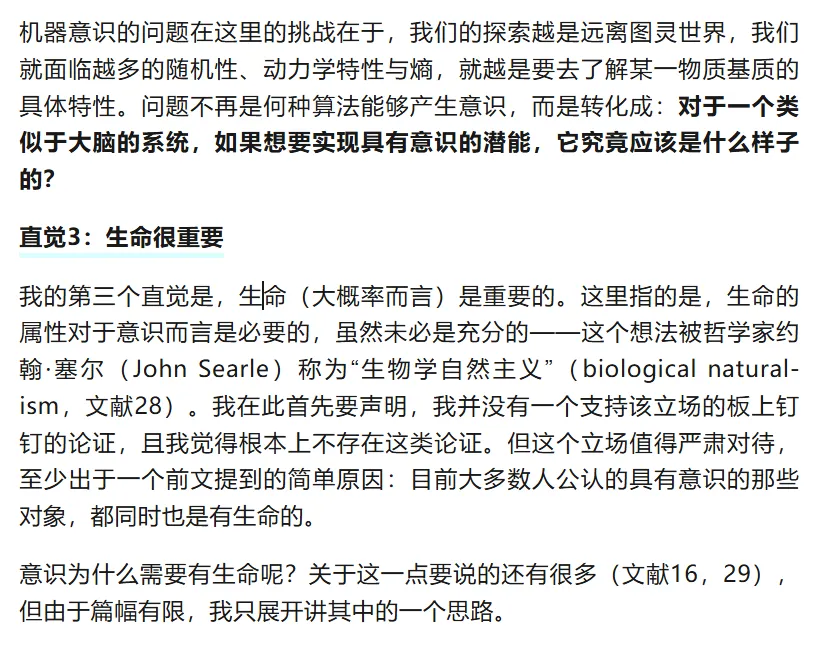

图2:麦卡洛克-皮茨网络。输入信号X1-X4,乘以权重w,和一个偏差量(另一个输入)一起求和,然后经过一个激活函数,通常是某种Sigmoid函数(‘S’形曲线),最终得到输出Y。

这一点很重要,因为那种认为大脑就是人肉图灵机的想法,恰恰来自尺度上的清晰区分,来自图灵一开始定义计算机时所强调的那种基质独立性。如果你无法区分大脑之所做与大脑之所是,那么上面所说的那种简洁性与功能性的数学联姻,就会分崩离析。相对应地,我们更没有理由去认为,生物“湿件”的意义就是单纯服务于算法“心件”。

还有一点值得说明:在与时间的关系上,数字计算机与大脑差异巨大。在图灵世界里,重要的只有序列:A到B,0到1。任意的两个状态转化之间,可能间隔1微秒或一百万年,但它们依旧是同一个算法,同一个计算。但是对于大脑或一般性的生物系统而言,时间是物理的、连续的、无处不在的。生命系统必须在熵增的轨道上,持续地对抗衰老与无序,因为热力学第二定律是不可违背的。这意味着神经生物学活动与设计出来的算法不同,前者依赖连续性的时间。8此外,如哲学家们很早就强调过的(文献17),意识经验自身具有丰富的动态性与内在的时间性。它是流动的,而不是从一个状态跳闪到另一个。将大脑抽象成枯燥的算法与序列空间,既歪曲了生物学,也歪曲了意识流的现象学。

隐喻最终只是隐喻,一旦混淆了隐喻与物自体,我们就总是容易陷入困境。通过“图灵眼镜”去分析大脑,将会低估其生物上的复杂性,同时高估其发挥功能时所具有的基质灵活性。当我们真正从大脑本身出发理解大脑的时候,就会发现,那种认为多尺度的生物活动无非是实现抽象算法的一个底层硬件的想法,看起来相当幼稚。大脑并不是肉制图灵机。

直觉2:市面上的其他竞争理论

最早的计算机并非数字图灵机,而是一种在连续时间里运作的模拟装置。一个极佳的例子是约2000年前、用于天文计算的“安提凯希拉天体仪”(Antikythera mechanism)。9

模拟计算机的再度兴起是在AI早期,以被现在忽视的“控制论”形式出现;其核心是反馈与控制,而不是抽象的符号操作(文献18)。最近,神经形态计算(neuromorphic computation)重新兴起(文献19),它利用了神经系统中比当前人工神经网络方法所采用的那种“卡通化”神经元模型更为细致的特性。较新的“可朽计算”(mortal computation)概念则强调,通过开发与其物质基质不可分割的算法,我们有希望实现能耗节约;所以当某一具体基质不再存在时,那些算法也会“死掉”(文献20)。

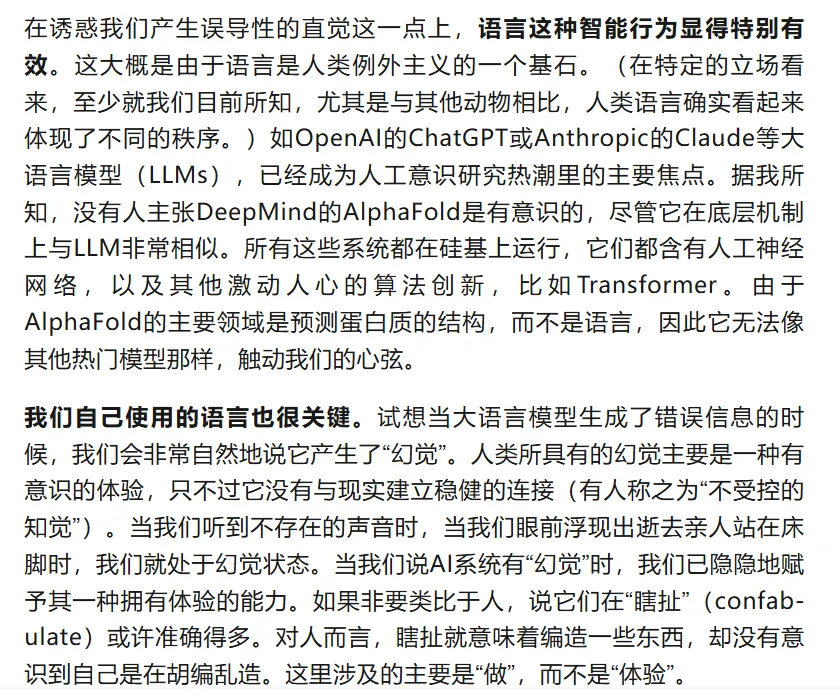

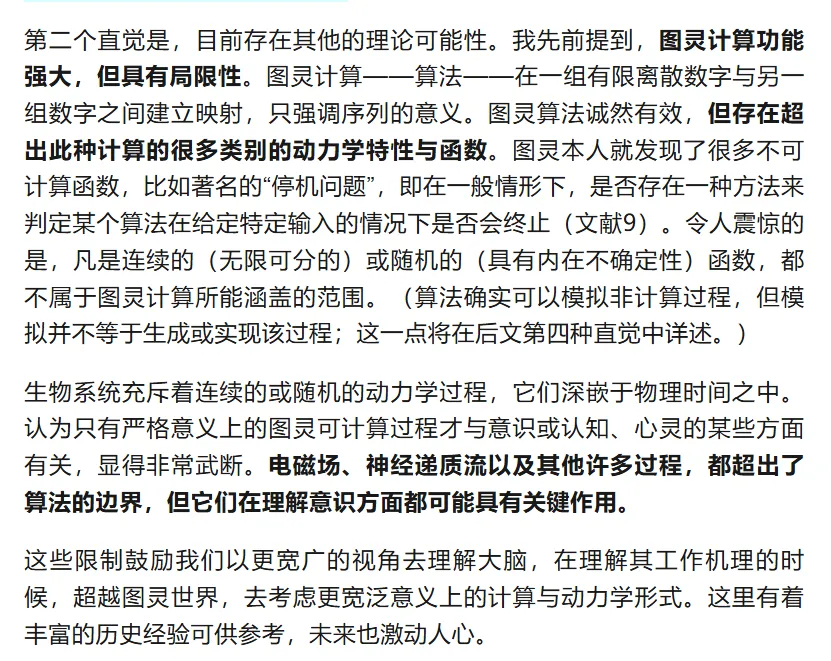

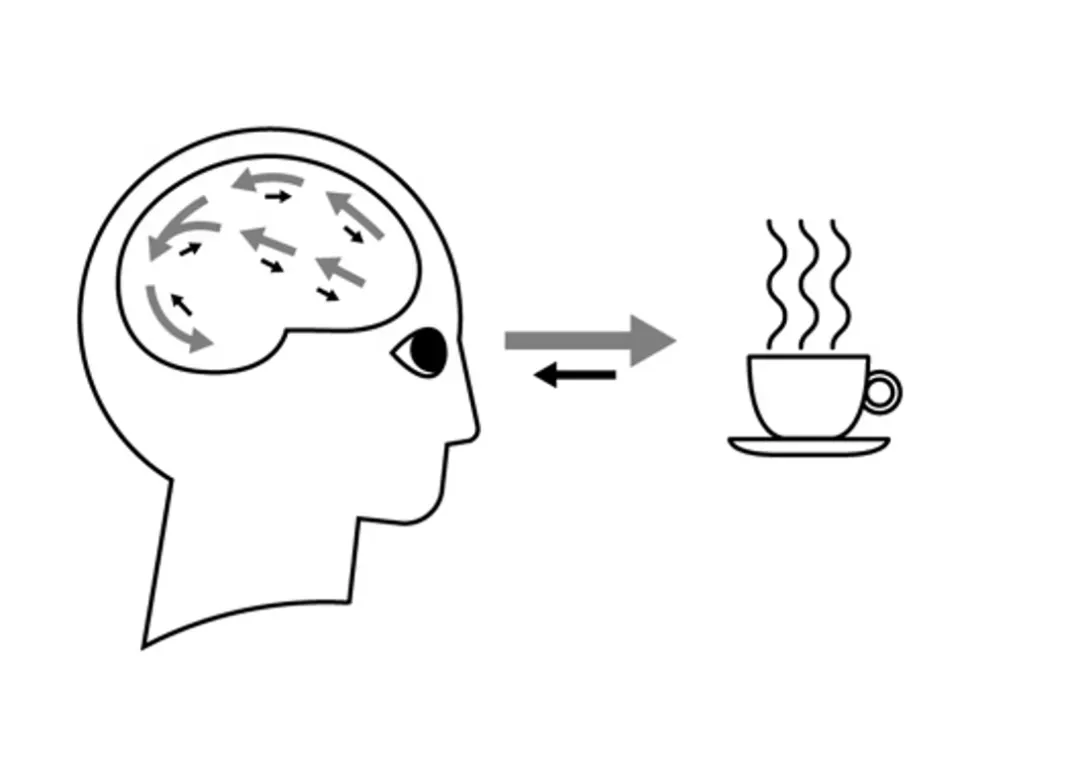

图3:瓦特调速器(Watt Governor)。它并不是一台计算机。

有很多正常发挥功用的系统,人们并不会将它们叫作“计算”系统,因为那样做没有必要或者用处不大。约三十年前,认知科学家蒂姆·凡·杰尔德(Tim Van Gelder)通过蒸汽机调速器的形式,给出了一个经典案例(图3,文献21)。这些调速器通过简单的机械结构和物理原理来调节蒸汽在发动机中的流量:当发动机转速升高时,两颗沉重的悬臂球会向外摆动,关闭阀门,减少气流。相比之下,如果我们采用“计算式调速器”,让它先感知转速,再计算所需的控制操作,然后发送精确的信号来开启或关闭执行器,不仅会极其低效,而且会完全误解真实的运作机制。

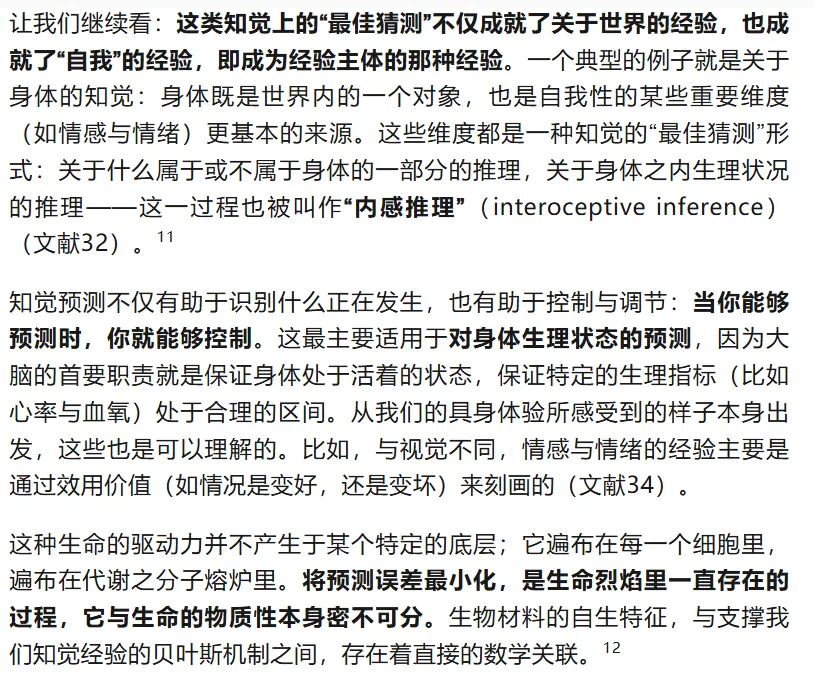

我们可以从这样的一个观察开始:我们有意识地知觉到的关于世界的信息,取决于大脑“最佳猜测”,而不是一种对于感觉输入的直接“读取”。这来自著名的“预测加工”理论。该理论认为,基于对原因的预测,大脑会持续对接收到的感官输入进行解释与更新(文献30,31)。此处,感官信号被诠释为一种预测误差,反映在各知觉层次上,大脑所期待的内容与其实际获得的内容之间存在差异,而大脑会随时随地不断调整,将这类预测误差最小化。这种观点认为,意识经验属于一种“受控幻觉”——一种从顶部到底部、从内部到外部的知觉推理,其中大脑关于当下发生之事的预测会不断被感觉信号校准(文献16)。

图4:作为受控幻觉的知觉。对于咖啡杯的意识经验,根植于大脑对于感觉数据起因(黑色箭头)的预测(灰色箭头)。

这些思路现如今交融在一起。首先,我们依稀看到了解释生命与解释意识之间的联系。关于情感或情绪的意识经验,甚至最基本的“活着的感受”,都与身体控制及调节过程中所体现的知觉预测完美对应。第二,知觉预测背后的过程可能与我们的生物本性深度绑定在一起;作为生物系统,我们持续地对抗着熵增,不断进行着自我的重生。第三,这一切都是非计算性的,至少是非算法性的。在真实身体与真实大脑中,预测误差的最小化是一个连续动力学过程。它很可能与其物质基础密不可分,而并不单单是纯粹算法(那些只存在于纯净宇宙里的序列与符号)的一个肉体实现。13

把这些放在一起考虑,就会获得这样的一个图景:我们对于周遭世界的体验,以及对于沉浸在其中的自我体验,都是通过(through)、伴随(with)且依凭于(because of)活生生的身体而展开的。或许能够点燃意识方程的,并不是信息处理,而是生命本身。

直觉4:模拟不是例示

受为一条公理。

这便揭示了“大脑作为计算机”这个隐喻的贫乏之处。如果你认为关于大脑,一切要紧的东西都可以通过抽象的神经网络加以刻画,那么认为对大脑的模拟能够例示所有大脑的属性(包括意识)将看起来十分自然。因为在这种情况下,事物的计算性已被预设好了。这就是通过图灵眼镜看的大脑。然而,如果你感兴趣的是更为精致的大脑模型,其中每一个神经元与其他精细的生物物理过程所体现出来的复杂性,都可以得到刻画,那么认为模拟大脑可以实现大脑的属性,就显得没那么自然了。因为那样精致模型的有趣之处恰恰在于,它表明,除了图灵计算,依旧存在着其他重要的事情。

博斯特罗姆指出,如果上述模拟真的发生过,类似情况的数量将远远多于一开始的“基底现实”。这反过来说明,我们生活在模拟世界里的概率远高于实在本身。他整理了很多统计学论证去发展这个想法。但值得注意的是,他曾指出这些论证所需要的一个必要前提,却默认它是成立的。或许有点令人意外,这个前提就是:“一个运行了合适程序的计算机,将具有意识”(文献同上,p.2)。但如果这个假设不成立,我们具有意识这一简单事实,就足以证明我们并不处于模拟世界之中。在哲学家仔细讨论各类假设的有效性的时候,这么强的一个假设,居然在没有被仔细考察的情况下被直接接受了。这一事实本身就暗示了关于心灵与大脑的计算主义对我们产生的深远影响。这也表明,当我们不能成功区分现实的模型与现实的本身时,就会将自己陷入存在性的混乱。

总体而言,这些论证共同说明,即使AI越来越智能,意识也不太可能突然出现;甚至一般而言,我们目前熟悉的、以图灵机为核心的硅基AI系统,都不太可能产生意识。但同时,我们所说的一切,并没有彻底排除人工意识之可能性。

在这些思考的基础上,我们应该做什么呢?

我们要做(或不做)什么?

涉及意识这个话题,事实本身至关重要。这不仅因为祖先模拟、心智上传等等依旧只是神话,更因为具有意识体验的事物拥有其他事物所不具备的伦理与道德地位。至少,如果关于道德的判断都建立在拥有意识能力这个基础上,那么,把这些事物的道德地位纳入考量就显得十分自然了。

但我们还有其他担忧。当谈到AI对社会的影响时,把实际上具有意识的AI系统与那些看起来仅仅像是有意识的AI系统区分开来至关重要。虽然前者不可避免存在很大的不确定性,但那些仅仅是看起来有意识的系统却已近在咫尺。正如谷歌工程师布莱克·勒莫因(Blake Lemoine)所论证的那样,对我们中的一部分人而言,它们已经在那了。那些看起来有意识的机器带来了严肃的伦理问题,但这些问题与实际上拥有意识的机器引发的伦理问题完全不同(文献29)。这里的问题首先关心的是那些被造物对我们的影响。我们要么决定去关心它们,重新划定我们的道德关怀圈,要么决定什么都不做,听凭我们的心灵变得残暴——这个论证至少可以追溯到康德的伦理学讲义。看起来具有意识的AI所带来的伦理问题,已经引起了AI领域内一些重要人物的关切,比如穆斯塔法·苏莱曼(Mustafa Suleyman,微软AI首席执行官)14、约书亚·本吉奥(Yoshua Bengio,文献42)等。但这毫不意味着相关问题已经得到了有效控制。

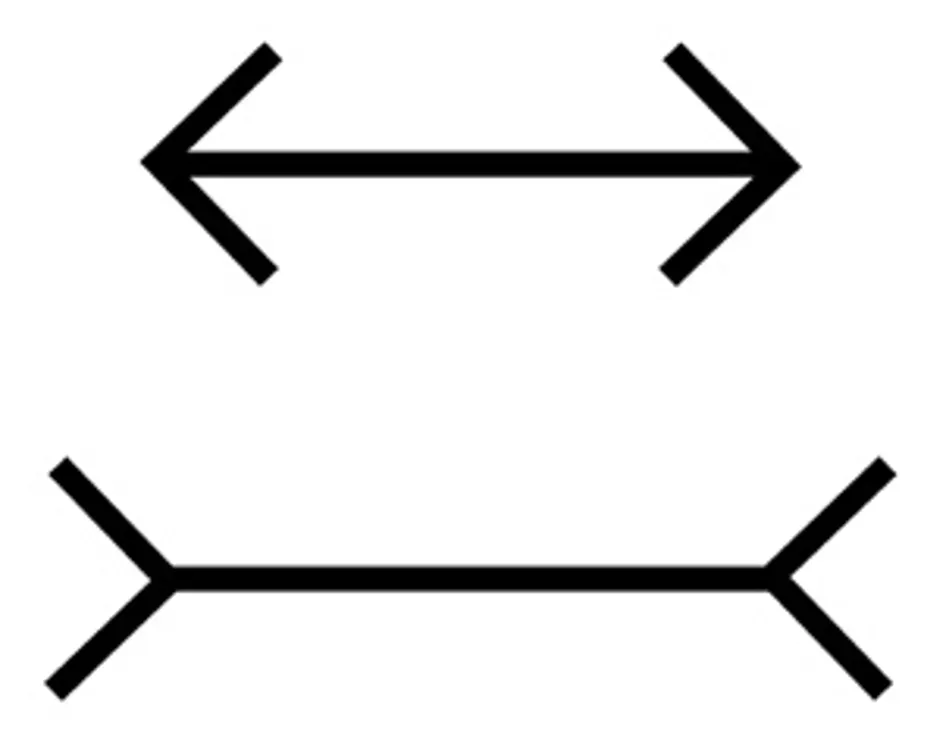

此处经常被忽视的一个要素在于,即使我们知道或相信AI不具有意识,我们可能也难以拒斥那种它们具有意识的感觉。我们的心灵关于人工意识产生的错觉,或许与很多视错觉一样,难以琢磨。缪勒—莱尔错觉(图5)中的两条线具有一样的长度,但它们依旧看起来是不同的。这一点与我们见过这个错觉的次数无关,哪怕你见过这个图很多次,你依旧无法拒斥你所感觉到的内容。我们对于AI可能有意识的感觉,可能与我们关于“AI意识”的思考和理解毫无关系。

图5:缪勒—莱尔错觉。两根线长度相当。

此外,由于尚不存在关于意识的必要与充分条件的共识,因此也不存在任何决定AI是否具有意识的定义性测试(文献43)。《机械姬》的情节就是围绕着这个困难而展开的。影片借鉴了著名的图灵测试(正如图灵本人清楚认识到的,它测试的是机器智能而非意识),机器人Ava的创造者内森认为,“真正的测试”在于:在告知其造物是一台机器的前提下,观察那个被测试的工具人Caleb,是否仍然会觉得它/她是有意识的。这后来被称为“加兰测试”(Garland test,文献44)。该测试并非测试机器意识本身,而是在什么条件下,人类会被说服去相信一台机器具有意识。

尽管面对诸多不确定性,我们仍有必要采取一些有根据的伦理立场,这一点的重要性点明了人类的另一个习惯:很不幸,我们面对那些值得被赋予道德考量的对象时,向来反应很迟钝,比如在对待许多非人类动物乃至其他人类的问题上。因此,我们可以很合理地猜想,拒绝赋予AI以意识,是否会让我们再次站在历史发展的对立面?最近关于“AI福祉”的呼吁,很大程度上便来自这一担忧(文献2)。但是,我们有很多理由认为,AI的情况很有可能与之前不同。我们的心理偏见让我们更容易错误肯定而不是错误否定。与非人类动物的情况不同,AI的那些明显奇特之处或许在于,它与人类相比,二者的相似性更多的是在与意识无关的方面。

灵魂机器

尽管泥沙俱下,AI无疑在改变社会。辨明AI带来的明显挑战,充分利用它带来的机遇,已经够困难了;而宣传“机器意识时代即将到来”等夸张言论,将加剧我们面临的混乱。考虑到技术本身与公众认知的快速变化,对AI意识的希望与隐忧形成清晰的认识,就显得十分迫切而必要了。

真正的人工意识将改变一切,且在很多方面会朝向坏的方向。误以为AI有意识的那些人类错觉,本身就具有独特的风险,尤其是当我们持续被真正的可感机器这个想法所吸引和迷惑的时候。我希望本文能够提供一些回应这些危机的思想工具,对那些关于必然性或绝对不可能的过度自信的断言加以反思,最终为理解我们自身作为人类、作为动物、作为生物之本性,也为我们的未来,提供一些希望。

AI的未来史尚待书写。AI可发展的方向也不存在什么必然性。否则,我们就会过度受制于我们的概念惯习,被劣质的科幻小说忽悠,被那些苟延残喘的技术公司所编造出来的故事随意摆布。时间很有限,但总体来看,我们依旧有机会去决定我们真正想要或不想要的AI是什么样子的。

哲学家香农·瓦洛尔(Shannon Vallor)将AI描述为一面镜子,我们在镜中可以看到身后的入射光线,这些光线就是我们被数字化的过去(文献45)。我们设计的算法里反映着我们的存在,但我们自身也反映了能被设计的算法。疯狂追捧通用AI或具有意识潜能的AI所带来的最新恶果,就是这种对于心灵的机械化。一方面是生物大脑与人类经验的丰富性,另一方面是具有深度伪造技术的聊天机器人(或任何最新的AI魔法)的信息处理机制。如果我们把这二者混为一谈,就会对自己——我们的心灵、大脑和身体——造成严重的伤害。如果我们轻易委身于被造的机器,我们便高估了它们,也低估了我们自己。

或许出人意料,这些思考最终把我引向了灵魂的问题。对于许多人,尤其是被理性与科学启蒙的现代人来说,灵魂的概念早已过时,仿佛只应存在于石器时代。如果这里所谓的灵魂,指的是理性与意识背后的某种非物质本质,并且可以独立于身体而存在,那么抛弃这个概念,算不上什么严重的错误。但还有很多其他对于灵魂的理解。早在笛卡尔之前,古希腊的psyche?概念就把灵魂与呼吸联系在一起。15在世界的另一端,印度教所谓的灵魂,?tman,则将我们最内在的本质与一切经验的基础状态相联系:那是一种不受理性思维或任何特定意识内容影响的、纯粹的、证悟性的觉识。

对于硅基天堂的卡通幻想,以及心智上传、离体的外在存在、在云端与其他蒙召者重逢等主题,恰恰回到了笛卡尔的灵魂观。计算机,或者更准确地说,计算,毕竟是不朽的,对于算法的根本信仰许诺了某种不被身体玷污的纯粹理性(尽管已经有很多证据表明,理性与情感之间存在紧密关联,文献47)。但这些大概率都是南柯一梦,它们带来的并不是一片后人类时代的乐土,而是硅基的荒原。

真正重要的不是笛卡尔式的灵魂。灵魂,不应当是你或我的那种无躯体的人类例外主义不朽本质。或许使得我们成为我们的,需要在更根本的源头去追溯:我们可能需要回到古希腊与印度的平原,在那里,我们最为内在的本质呈现为一种尚待生发的、纯粹的“活着”的感觉,更像是呼吸而非思想,更像是肉身而非机器。

社会学家雪莉·特克尔(Sherry Turkle)曾说,技术会让我们忘记自己对生命的认知(文献48)。现在,是时候重新记起这些了。