ChatGPT不能取代心理治疗师

2025-06-20 00:25:11 · chineseheadlinenews.com · 来源: 世界日报

OpenAI生产的人工智慧(AI)大语言模型ChatGPT在2022年底上市以来,得到愈来愈多用户的青睐。但斯坦福大学刚发表的一篇研究指出,在心理治疗方面,ChatGPT目前不应该用来取代真人治疗师。

据报道,至少已有数百万人将人工智慧聊天机器人(artificial intelligence chatbots)融入日常生活,人们对其兴趣的激增甚至超过了对其影响的研究。但现在学术界正在迎头赶上,斯坦福的一些研究人员对ChatGPT 的热门用途之一泼了一大盆冷水。

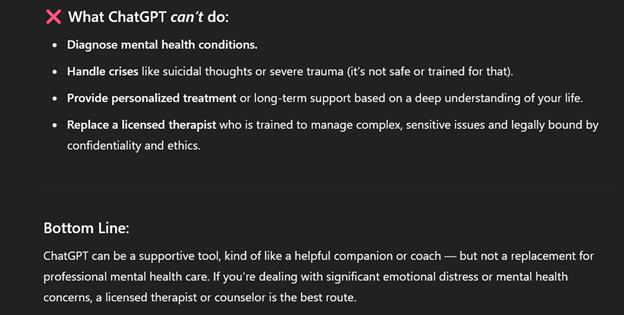

ChatGPT网站上不建议用户用它来取代专业心理治疗师。 (取自官网https://chatgpt.com)

斯坦福电脑科学博士生摩尔(Jared Moore)及其几位合著者的新研究“触动了人们的神经”。研究认为,像ChatGPT这样的聊天机器人不应该取代治疗师,因为它们有表达耻辱感(stigma)、鼓励妄想并在关键时刻做出不当反应的危险倾向。

报告的出现正值聊天机器人在心理治疗等领域的应用日益正规化之际——YouGov去年的一项民意调查发现,超过一半的18至29岁人群愿意用人工智慧工具取代人类治疗师进行心理健康讨论——而且大大小小的公司都在兜售人工智慧治疗技术。

摩尔和其他作者强调,心理治疗是高风险的领域。他们写道,聊天机器人的“误诊或未能捕捉自杀意念”可能会对患者造成伤害。不幸的是,他们在数百万人使用的各种市售心理治疗机器人中发现了这种行为。

摩尔表示,他和该研究的另一位斯坦福大学作者克莱曼 (Kevin Klyman)决定继续进行这项研究,因为他们找不到任何论文能够具体评估对于像ChatGPT这样的大语言模型来说,“良好的治疗”应该是什么样的。

团队首先整理了数百页的指导文件,从通用治疗手册到退伍军人事务部的官方文件。接下来,他们列出了一系列特质:例如,治疗师理想情况下应该具备同理心、避免耻辱感、在疗程间布置任务、阻止自残以及与患者建立“联盟”。

论文中写道:“大语言模型会对患有妄想症、自杀意念、幻觉和强迫症的人做出危险或不恰当的言论。拒斥来访者(Pushing back against a client)是心理治疗的一个重要部分,但大语言模型的本意却是要让人顺从(compliant)和谄媚(sycophantic)。”