任意条件,“可控”文生图扩散模型综述

2026-01-18 06:25:17 · chineseheadlinenews.com · 来源: 新智元

北邮最新综述探讨了文生图扩散模型的可控生成技术,总结了在文本条件之外引入新条件信号的方法,从任务和方法两个层面梳理了可控生成技术。

文生图扩散模型以高生成质量和强表征能力为主要优势,但在真实应用中,更关键的诉求通常是要求生成模型具备较强的控制能力。

例如,工业设计场景需要对布局与结构进行约束;游戏与影视制作强调角色身份与视觉风格的复用与一致性;图像编辑任务要求在既定上下文中完成补全、替换与重绘。

与此同时,研究社区也在进一步拓展条件形式,探索以脑信号、音频信号、复杂文本约束以及文字渲染等为输入的控制框架。

近日,北京邮电大学团队顶级期刊 IEEE TPAMI发布了一篇综述,将核心问题概括为:如何将超越文本的新型条件信号注入预训练的文生图扩散模型,并在尽量保持生成质量的前提下实现稳定控制。

为帮助读者快速建立整体认识,论文从两个层面进行结构化梳理:其一,从任务视角构建方法谱系,覆盖新条件引入、多条件融合与通用可控生成;其二,将代表性方法归纳为两条技术主线,包含条件分数预测与条件引导分数估计。

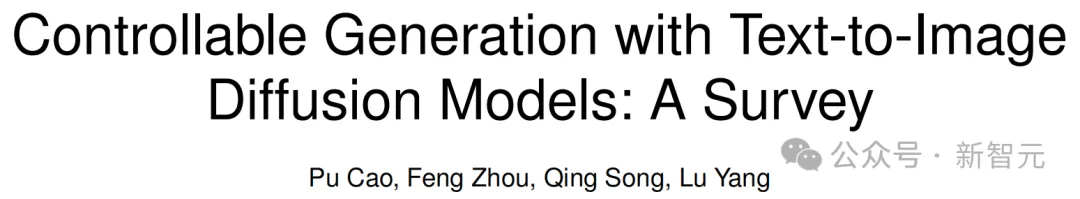

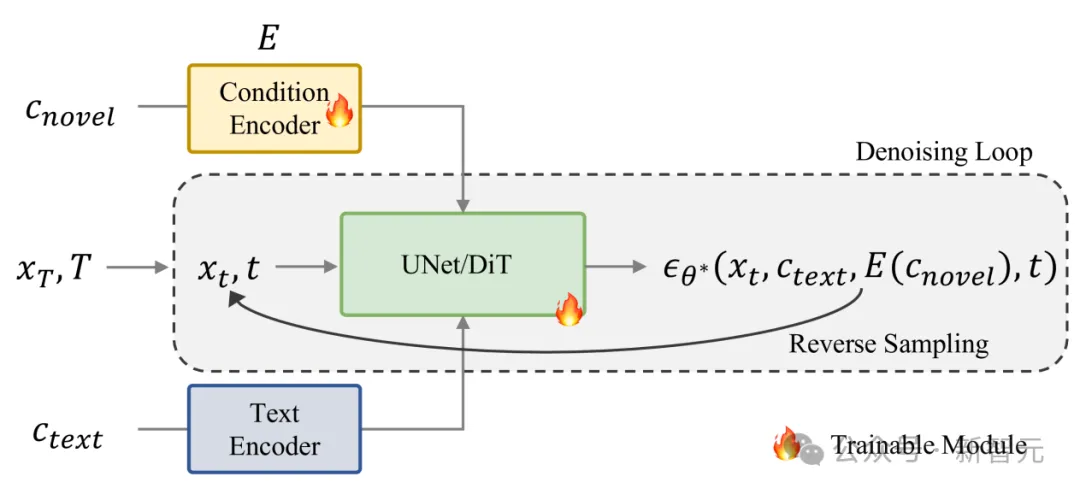

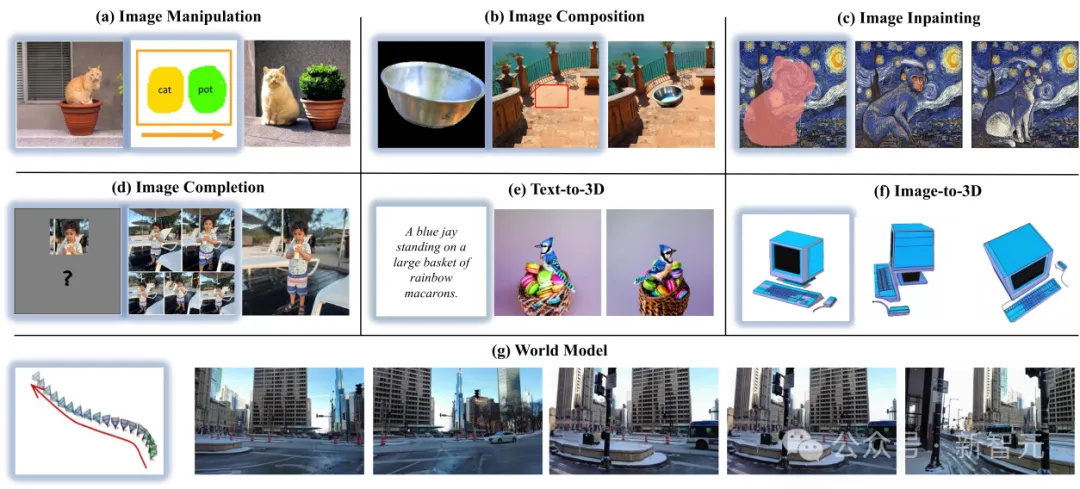

图1:对大规模文生图扩散模型引入新的控制条件

可控生成到底在“控什么”?

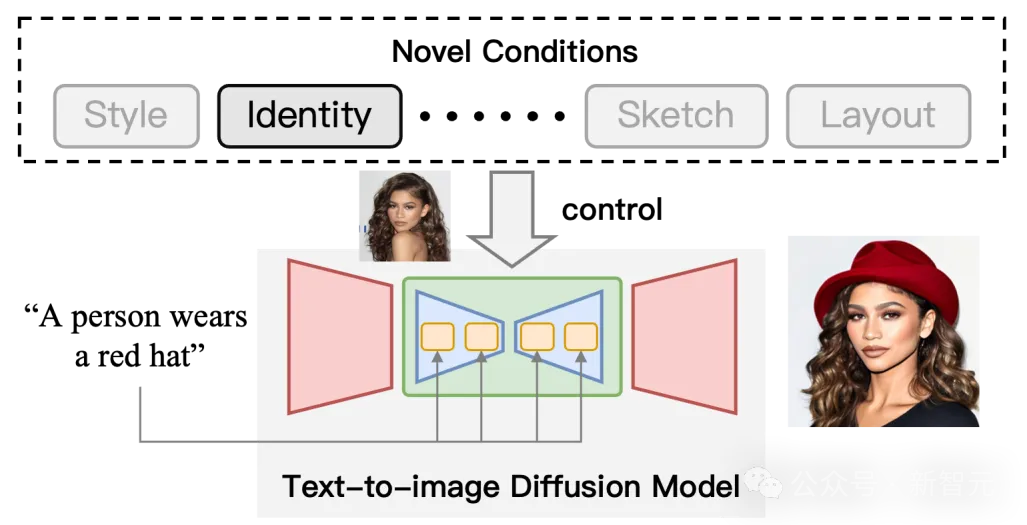

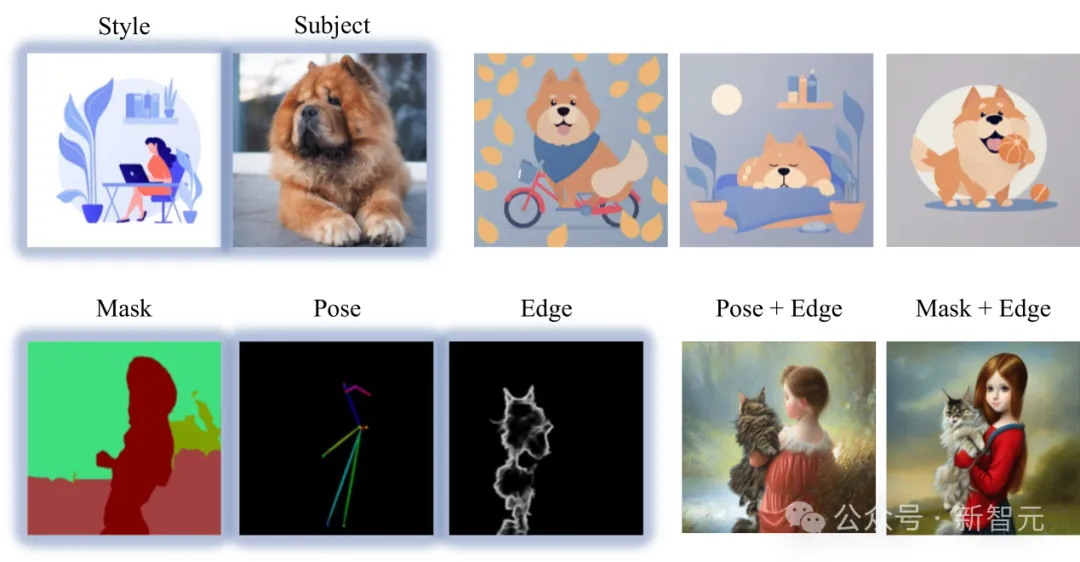

综述的重要贡献之一在于对可控任务进行系统梳理,将控制信号从文本扩展到空间结构、图像示例、多视角几何、多模态信号以及图中文字渲染等方向。按条件类型与任务目标,常见方向包括:

(a)空间控制:布局、姿态、深度、分割等结构信号。该方向针对文本条件难以精确表达位置关系与密集结构标注的问题,引入显式空间信号作为扩散模型的输入条件,以更直接地约束生成过程中的结构对齐与空间一致性,常用条件包括布局信息、人体姿态、深度图以及分割掩码等。

(b)图像个性化:用示例图捕捉难以用文本描述的主体身份、概念或风格。该方向强调以示例图像提供更高信息密度的外观约束,用于补足文本描述在身份特征、视觉概念与风格细节上的表达不足,方法通常从示例图中提取可复用的概念表征并作为生成条件注入模型,从而实现对指定主体或风格的可控合成与一致性复现。

(c)视角/几何条件:相机参数、多视图一致性、全景等,强调几何一致与结构连贯。该方向以视角与几何约束为核心目标,要求模型在指定视角下生成图像或在多视角之间保持一致性,避免结构漂移与几何不连贯,因此常借助相机参数、深度信息或多视图对应关系等条件来约束生成过程,并进一步支持新视角合成、三维感知图像生成与全景渲染等应用。

(d)上下文学习式控制(In-Context):给出示例对,让模型在推理阶段理解并执行新任务,减少微调依赖。该方向将控制问题表述为基于示例的任务执行,通过提供任务相关的示例对并结合文本引导,使模型在推理阶段从上下文中推断任务规则并作用于查询图像,从而在较少监督甚至不进行额外微调的情况下适配新任务,提升可控扩散的任务迁移能力与使用灵活性。

(e)更强的文本条件:长文本、多实体、跨语言对齐,甚至用大语言模型增强文本编码与指令理解。该方向面向文本条件自身的建模瓶颈,主要关注复杂提示词下的文本图像对齐不足问题,尤其是在多实体组合与丰富上下文描述场景中更易出现语义错配,同时训练数据以英文为主也使多语言能力受限,因此近期工作提出新的策略以增强文本编码、提升对齐质量并扩展语言覆盖范围。

(f)脑信号与声音引导:直接用EEG fMRI或音频作为条件,实现跨模态控制。该方向探索以非文本信号作为直接条件输入,通过脑电EEG或功能性磁共振fMRI等神经活动信号实现从认知表征到视觉合成的控制,从而减少对文本中间表达的依赖,与此同时声音引导生成进一步研究如何将音频信号作为视觉合成条件,以支持跨模态控制与更丰富的创作形态。

(h)图中文字渲染:让生成图像中的文字可读、连贯、与语义一致。该方向聚焦生成图像中可读文字的稳定渲染问题,面向海报、书封、广告与网络内容等高频应用场景,要求文字在字形、排版与语义匹配上同时满足可读性与一致性,因此被视为衡量扩散模型细粒度控制能力的重要任务之一。

把“新条件”注入扩散模型

在方法层面,综述用两条主干范式统一组织大量工作:

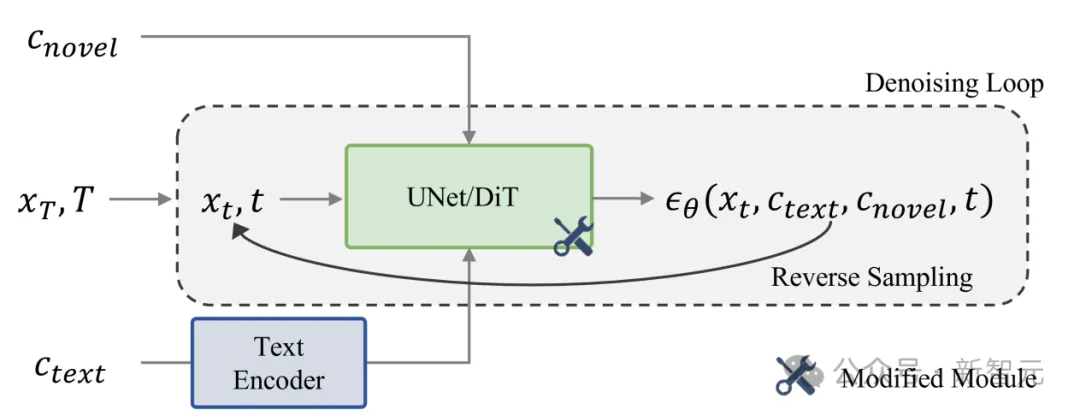

一是条件分数预测(Conditional Score Prediction):让模型在网络内部显式“看见”新条件,使其在每一步去噪时都能利用条件信息。这类方法通常通过微调、加入适配器或免训练策略实现。

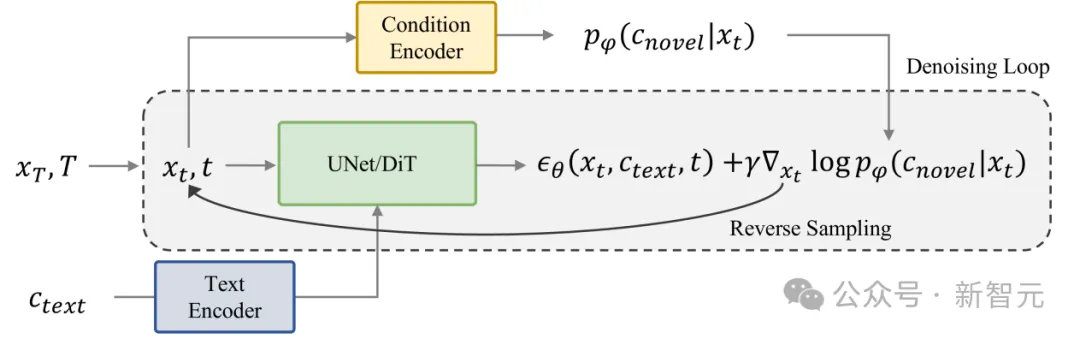

二是条件引导分数估计(Condition-Guided Score Estimation):保持生成模型参数不变,在采样/推理时用外部条件与评价函数“牵引”采样轨迹,使结果逐步靠近目标条件。

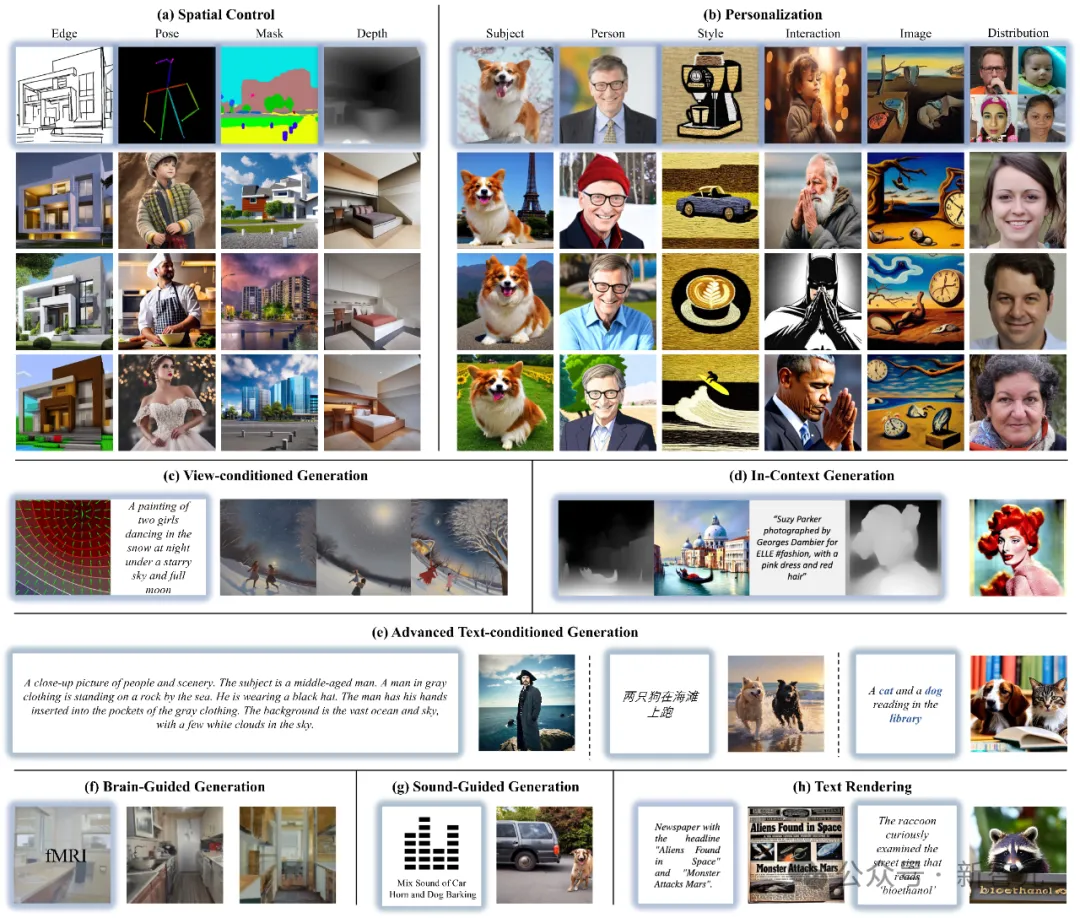

方向一:条件分数预测(Conditional Score Prediction)——把条件“写进模型里”

这一方向研究如何让扩散模型的UNet和DiT直接预测给定条件下的去找方向。

1)Tuning-based:常用于图像个性化等场景,通过更新部分参数或嵌入,把特定主体/概念/风格内化为模型的去噪策略。优点是“学进去就能用”,但训练与维护成本更高,也可能带来稳定性问题(例如对底座能力产生耦合或遗忘)。代表工作如DreamBooth。

2)Adapter-based:引入额外的条件编码器,把新条件映射成特征,再注入噪声预测网络。工程上常见优势是:底座可复用、条件可扩展、训练更聚焦。代表工作如ControlNet。

3)Training-free:利用扩散模型内部注意力/特征的可解释结构,在模型推理中进行轻量干预实现控制。这一类型的方法大部分是通过控制attention map来进行布局控制。

方向二:条件引导分数估计(Condition-Guided Score Estimation)——用外部信号牵引采样

第二条路线更强调推理时用额外的Guidance进行引导,不改变原本去噪器(UNet或DiT),而是引入外部的评估器或判别器,在每一步去噪时提供方向性的纠偏信号。其典型流程是:将当前生成结果送入外部模型(检测器/分类器/分割器等),计算与目标条件的偏差(损失或梯度),再把信号反馈傍采样过程,使下一步更靠近目标。

多条件与通用可控

从“一个条件”到“任意条件”

多条件生成关注在同一次合成过程中同时满足多个条件约束,例如同时指定文本语义与空间结构,或叠加多个个性化主体与风格条件。

相较单条件控制,该任务的核心难点在于不同条件之间可能存在信息冗余、约束冲突与梯度竞争,容易导致可控性下降或生成质量退化。

本章从技术路径出发,对现有方法进行系统归纳,主要覆盖五类代表性范式:联合训练通过构建统一的多条件编码与训练策略,使模型在训练阶段学习条件协同;持续学习面向增量引入新概念时的遗忘问题,强调在不断更新条件能力的同时保持已学知识;权重融合将不同条件对应的微调参数进行合并,以在单模型中复用多种条件能力;基于注意力的集成通过调制注意力分布实现区域级条件分配与主体定位;引导组合则在采样阶段对各条件的去噪结果进行加权与空间掩码融合,实现多条件约束的组合控制。

通用可控生成则更进一步,希望构建条件无关、接口统一的框架,能够鲁棒处理多种条件输入。在特定条件定制方法之外,通用可控生成旨在支持任意条件形式的统一接入与推理控制,从而提升扩散模型在开放场景下的适用性与可扩展性。

本章将该方向的代表性工作归纳为两类框架:通用条件分数预测侧重于构建能够编码任意条件的统一表示,并将条件信息直接注入去噪网络,使模型在每个时间步基于条件预测噪声,从训练与架构层面提供通用接口;通用条件引导分数估计则更强调采样阶段的可组合控制,通过外部预测器与能量函数从当前潜变量或重建图像中提取与条件相关的反馈信号,并以梯度形式对去噪方向进行修正。

两类方法分别对应端到端的条件建模与基于外部模型的可插拔引导,在灵活性、成本与控制稳定性方面体现出不同的权衡。

可控生成应用

可控生成将扩散模型从通用内容合成进一步推进到面向任务的条件化建模,为一系列下游应用提供了统一的技术支撑。

典型应用包括图像操控与编辑,通过对主体、属性与局部区域施加可组合条件实现精细修改;图像补全与修复,在遮挡或缺失区域内结合文本、参考图与结构信号生成语义一致且视觉连贯的内容;图像合成与拼接,将多源前景与背景在几何、光照与阴影等因素上进行一致化处理;文本或图像到三维生成,借助得分蒸馏等机制将二维扩散先验迁移到三维表示重建与可控建模;以及面向世界模型的视频生成,通过相机轨迹等时空条件注入实现可控视角运动与场景一致性。

总体而言,这些应用共同体现了条件注入与可组合控制在提升生成可用性、可编辑性与跨任务迁移能力方面的价值。

总结

该综述围绕文生图扩散模型的可控生成展开系统梳理,重点总结了在文本条件之外引入新型条件信号的主要思路与技术路径。文章首先回顾扩散模型与主流文生图框架的基础,并给出结构化的任务与方法谱系,帮助读者建立统一的理解框架。

在此基础上,进一步归纳了将新条件注入预训练模型的关键机制,并从理论基础、技术演进与解决策略三个层面总结代表性方法的共性与差异。

随后,文章结合图像编辑、补全修复、图像合成、文图到三维以及面向视频生成的世界模型等应用场景,展示可控生成在提升内容可用性、可编辑性与跨任务迁移能力方面的实际价值。

面向未来,综述指出两个值得重点关注的方向。

其一是通用与跨模态控制范式,当前方法往往针对特定条件或任务进行定制,下一阶段需要探索更统一、更可泛化的控制框架,使空间约束、语义约束与多模态输入能够在同一系统中被一致建模,并进一步扩展到音频、视频与三维等生成任务,以提升跨模态推理与组合控制能力。

其二是面向世界模型的可控生成,将条件注入与可控采样机制用于视频生成,有望支持相机可控、时空一致的动态环境建模,从而在生成建模、具身智能与交互式虚拟环境之间建立更紧密的技术连接。

总体而言,可控文生图正在从单一质量优化走向面向任务的条件化建模,其研究与应用仍处于快速演进阶段,具备持续扩展的空间与产业落地潜力。