Barry Barish主题演讲:十年新科学

2026-02-18 01:25:31 · chineseheadlinenews.com · 来源: 小乐数学科普

2月11日, 在UCLA(加州大学洛杉矶分校)举办的2026年AI科学盛典:AI for Science: Kickoff 2026(SAIR基金会项目启动会),上午第2场主题演讲,由诺贝尔物理学奖得主巴里·巴里什(Barry Barish)带来激光干涉引力波天文台(LIGO)发现引力波之后10年来的进展介绍,文末附专访内容。

巴里·巴里什(Barry Barish)

作者摘要

自激光干涉引力波天文台(LIGO)发现引力波以来,已过去十年。在本次报告中,我将回顾这一发现,并探讨过去十年间取得的进展以及涌现出的全新科学成果。

核心要点笔记(极简版)

1、AI 在物理学中影响远低于预期

科技突破多源于基础物理,但 AI 进入物理很慢,未真正推动核心科学突破。

2、根本矛盾:AI 黑箱 vs 物理依赖统计显著性

物理靠 统计显著性(如 5σ)判断发现真伪

神经网络是黑箱,无法给出统计置信度

→ 这是 AI 难以深度融入物理的核心障碍。

3、LIGO 引力波发现:AI 只做辅助,不做主发现

传统方法:25 万模板匹配 + 严格统计

AI 作用:加速识别、低延迟、支持多信使天文

定位:工具级提速,非理论突破。

4、引力波的科学价值

验证广义相对论,证明光与引力波同速

解释金、铂等重元素来自双中子星合并(千新星)

发现质量介于中子星与黑洞间的 “奇怪天体”,现有理论无法解释。

5、黑洞最大谜题

观测到近 100 倍太阳质量的黑洞,远超恒星坍缩理论上限,起源未知。

6、AI 未来要突破的关键点

让 AI 能给出可量化的统计置信度,不再是纯黑箱,才能真正改变物理学。

7、终极目标

用低频宇宙引力波直接观测宇宙开端(大爆炸早期)。

以下正文为完整演讲内容(含Q&A问答环节、采访内容):

巴里·巴里什演讲内容全文

我会穿插介绍我所参与的、大家比较熟悉的那个大型研究项目,以及人工智能正在我们的工作中产生影响的地方。但我也想顺便稍微谈一谈人工智能在物理学中的应用,以及一个事实:在某些方面,物理学可能并不是大家想象中那样,AI 已经产生巨大影响的领域。

回顾上个世纪,科技的进步绝大多数都起源于最基础的物理学。

激光的发明,源于爱因斯坦的一个理论;核磁共振仪(MRI),最初也来自核物理的另一个理论——这两项后来都拿了诺贝尔奖,之后人们才发现它们有实际应用。

而人工智能进入物理学的步伐,要慢得多。

我们到处都在用 AI,但我认为,它并没有真正以推动科学向前发展的方式在发挥作用。

我会解释为什么我这么认为,问题出在哪里——其实不是问题,而是局限性。

物理学真正成为一门学科,是从牛顿时代开始的。

牛顿教给我们科学方法:通过一套标准来检验,判断我们在实验室里、或是在理论推导中得出的东西是对还是错。

到了20世纪,这套方法被取代了。

我们依然在用科学方法,但已经不是牛顿那一套步骤。

如今,我们判断一个科学结论是否成立、是不是科学突破、或是一个科学装置是否可行,并进行定量判断的主要工具,是统计学。

我们用统计显著性来衡量一个现象是不是真实事件。

而传统人工智能、机器学习在物理学中应用的真正局限,本质上是:两者几乎“互相排斥”。

我们用的统计方法,和神经网络这类工具是不兼容的。

比如神经网络就是一个黑箱,我们无法从中得出统计显著性。

大家可以看希格斯玻色子的发现:我知道背后做了多少工作,看过所有内部笔记,也知道有多少现代技术被用来判断结果是否正确。

但在向同行展示成果时,用来证明它达到5个标准差的,依然是传统统计方法。

我还记得当年有这么一件事:马克斯·德尔布吕克(Max Delbrück)来到加州理工,由当时的校长默夫·戈德伯格(Murf Goldberger)带来物理系。

我当时还是年轻教员,试着和他合作,做粒子鉴别——在探测器里区分看到的是 π 介子、K 介子、电子还是光子。

但不管用神经网络还是嵌套神经网络,都给不出概率。

所以我们一直只能用统计方法来做。

这在过去是局限,今天依然是。

这也是我为什么要谈:AI 如今在物理学中到底扮演什么角色。

AI 现在确实开始在日常工作中发挥很大作用,我后面会讲到在我们的实验里是怎么用的,但它还没有达到根本性的作用,原因就是:目前版本的 AI 无法和统计方法兼容。

这就是我要讲的核心局限。

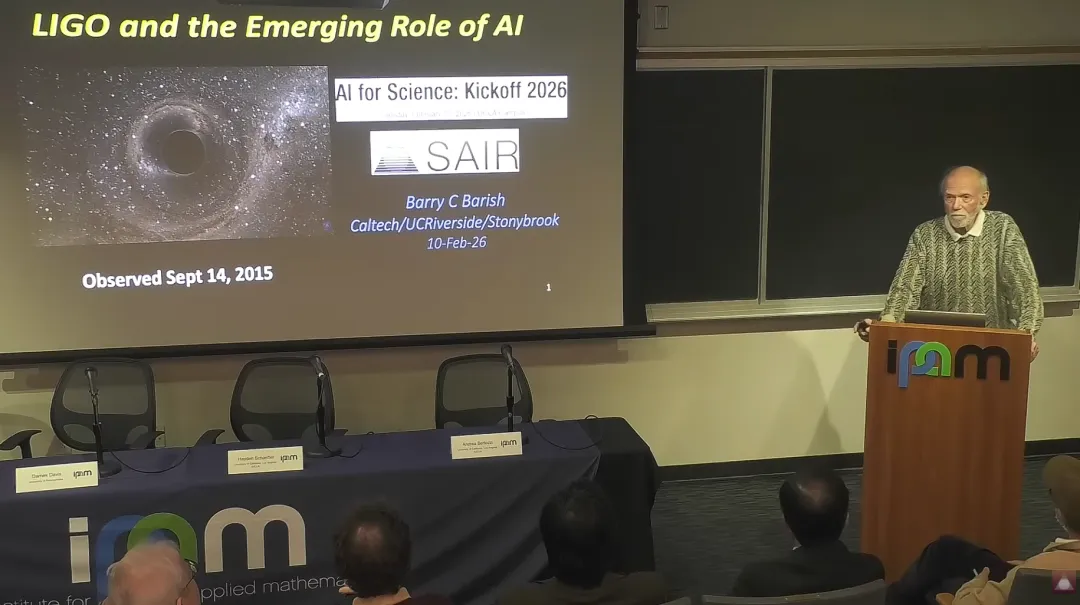

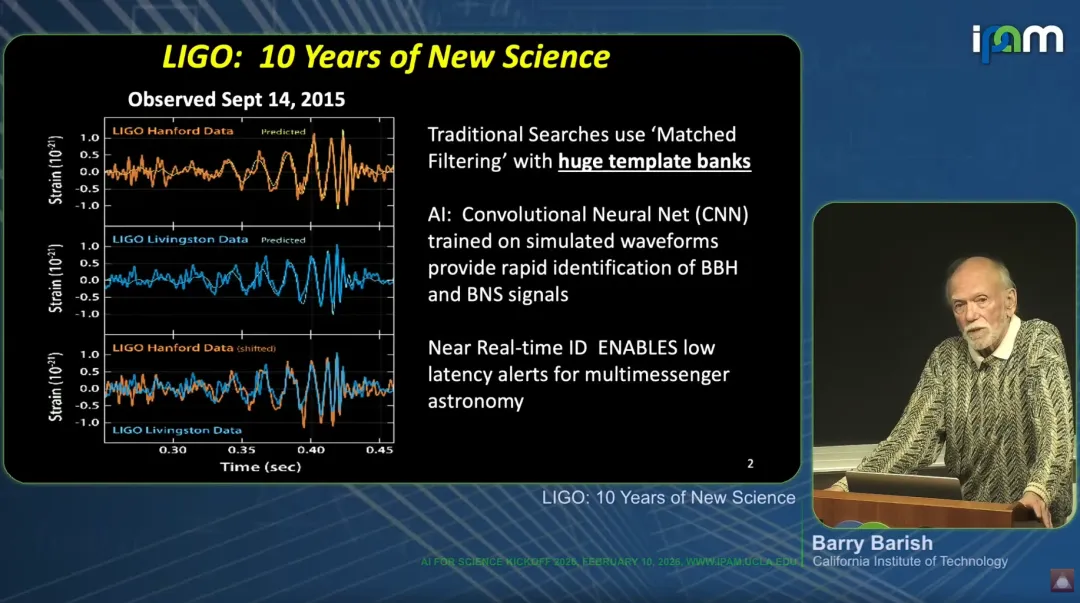

接下来是引力波的发现。

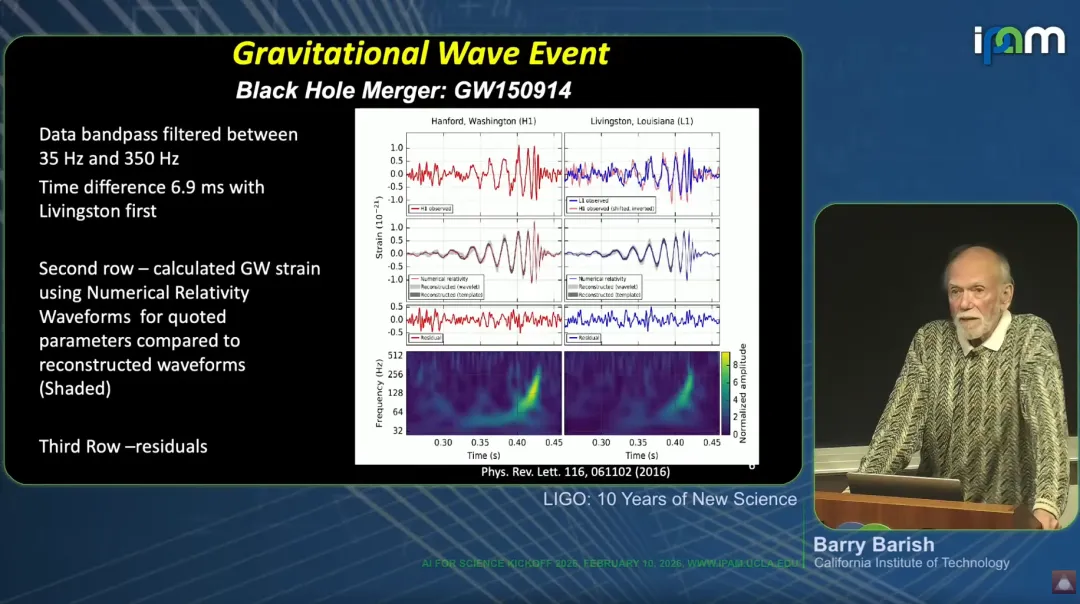

这张图来自我们大约20年前——不对,是10年前发表在《物理评论快报》上的文章。

这是两个黑洞的并合。

横轴是时间,从左到右是 0.21 秒;

纵轴的数据非常惊人:数量级是 10???。

我们造出了一台仪器,能够测量到10的21次方分之一量级的微小效应。

简单说一下这台装置:之所以有两张图,是出于置信度等考虑,我们建了两台不同的探测器。

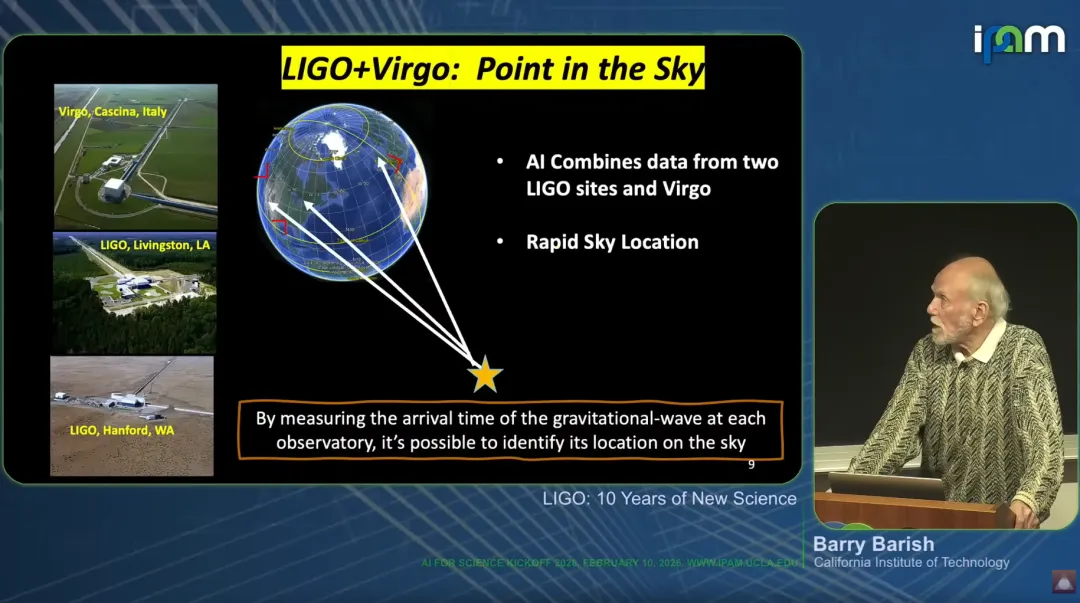

一部分原因是用两台、后来三台探测器,可以定位信号在天空中的位置。

横轴是并合过程:两个黑洞越靠越近,信号越来越强,最后并合在一起。

我们传统的探测方法叫模板库(template banks)。

我们用爱因斯坦方程,计算出两个黑洞、或黑洞与中子星之间所有运动学上可能的构型,做出大约 25万个模板,覆盖仪器能探测的参数空间。

然后对每一段数据,把计算出的模板和实测数据比对25万次。

我们基本就是靠这种方法发现引力波事件。

在人工智能方面,我们现在确实在用 AI,但我把它称为辅助性应用。

我们用卷积神经网络,在模拟波形上训练,让这一过程速度更快。

但对我来说,这算不上革命性的进步。

不过速度更快,确实让我们在引力波探测中能更快做出判断,告诉天文学家:我们可能看到了信号,你们可以把望远镜对准这个方向观测。

所以速度很重要,而 AI 能帮我们提升速度。

这是我们现在使用这些技术的一个方向。

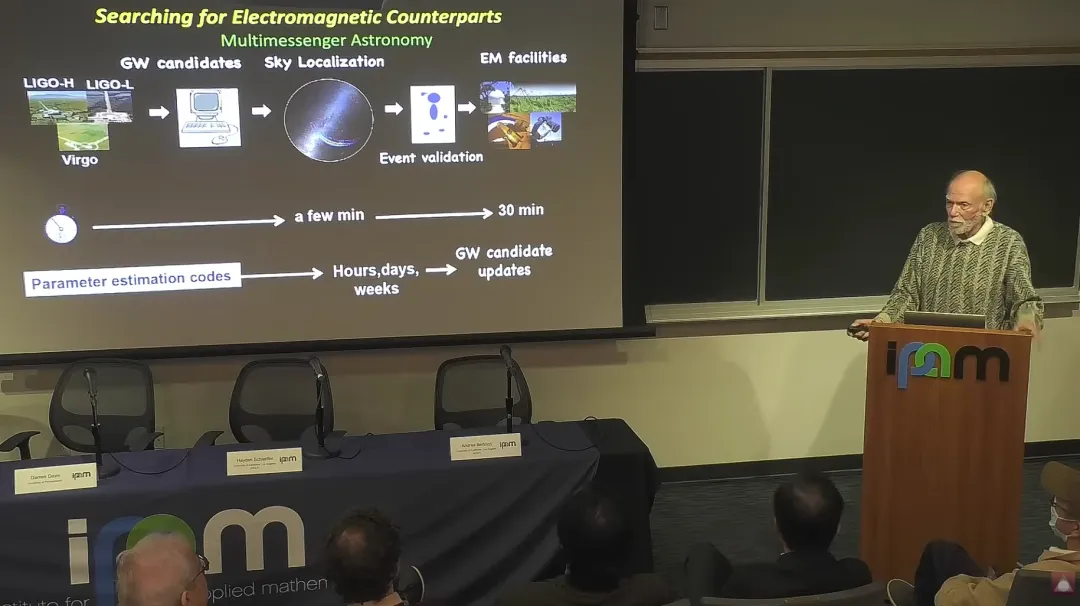

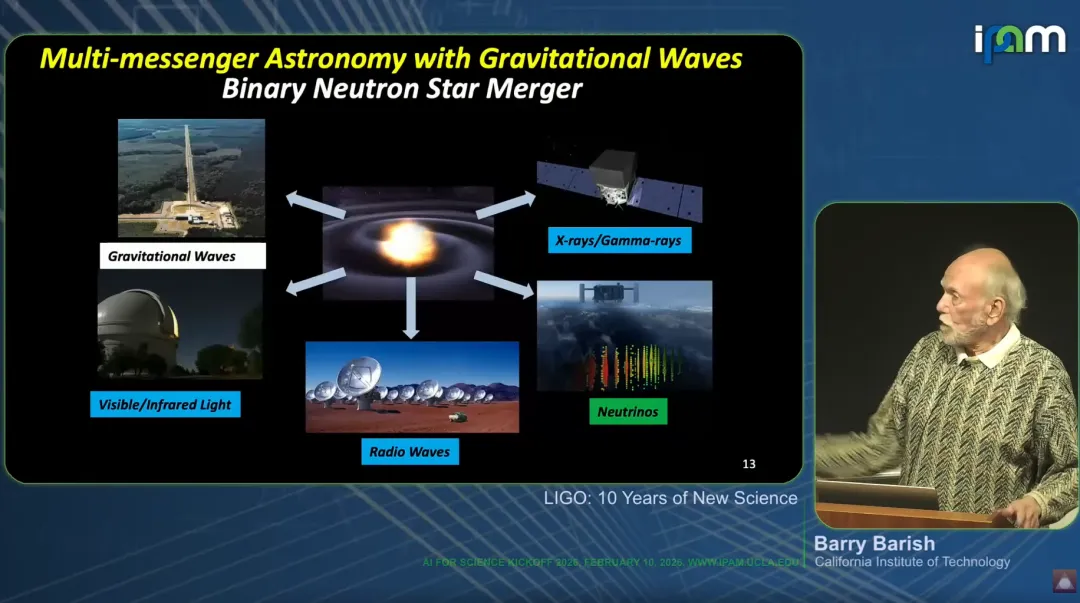

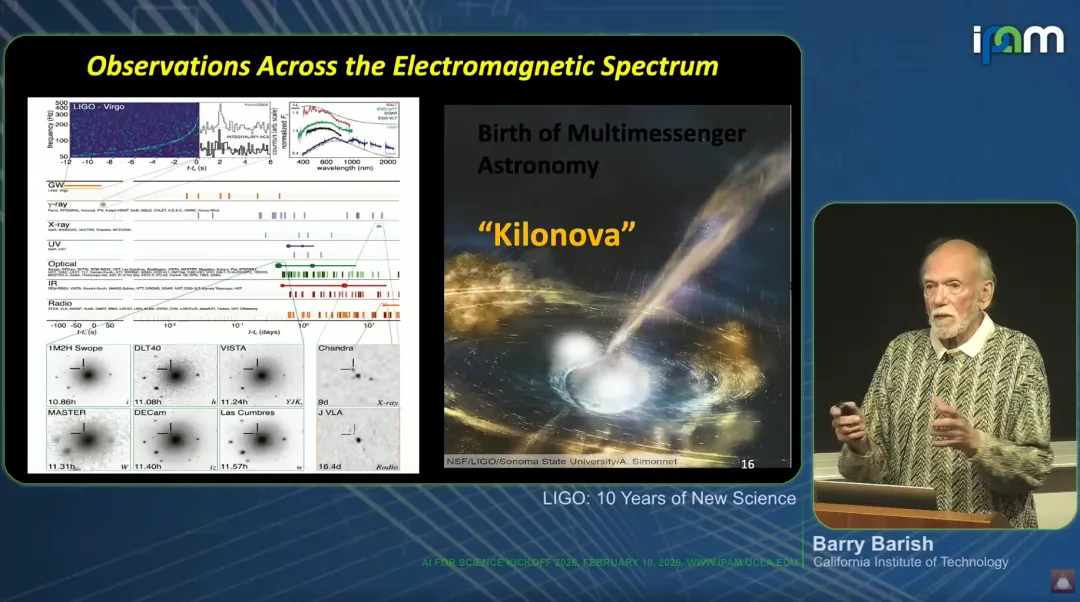

这种快速实时识别、低延迟,让我们得以开展所谓的多信使天文学。

也就是:在太空中观测同一个现象,同时用各种电磁波、可能还有中微子、以及引力波去观测它。

这就是我们追求快速探测的目标。

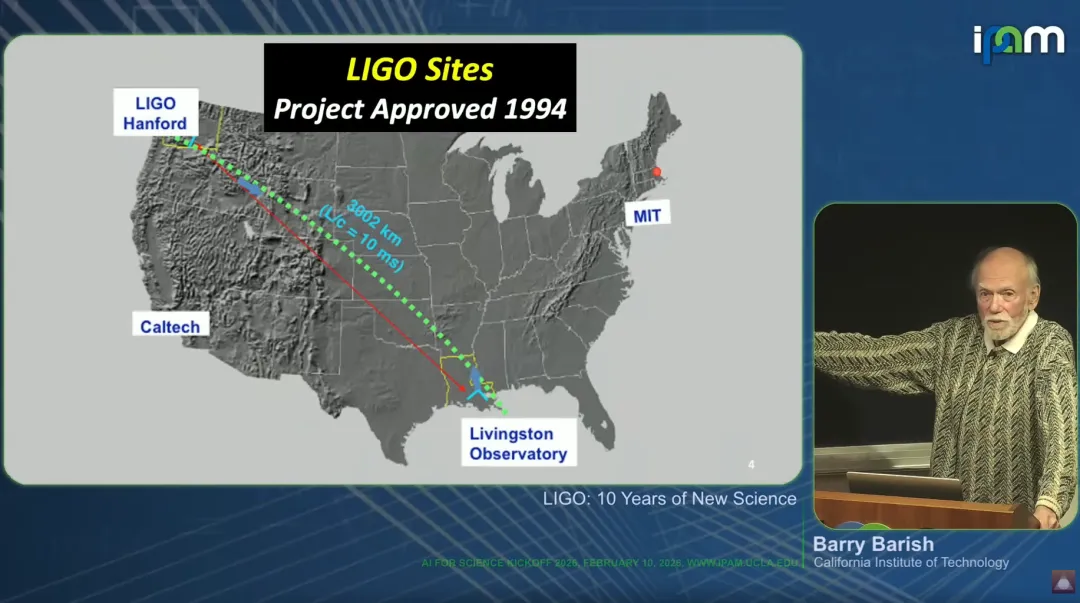

这就是 LIGO(激光干涉引力波天文台)。

它体量巨大,同时精度极高。

干涉臂长 4公里,共有两台:一台在华盛顿州汉福德,一台在路易斯安那州利文斯顿。

还有第三个合作伙伴,在意大利比萨附近,技术设计略有不同,今天就不多说了。

我们在90年代初向美国国家科学基金会提出这个项目,他们批准了。

政客们在批准基金时,出于政治考虑,把我们原本选的地址换掉了,但最终还是给了经费。

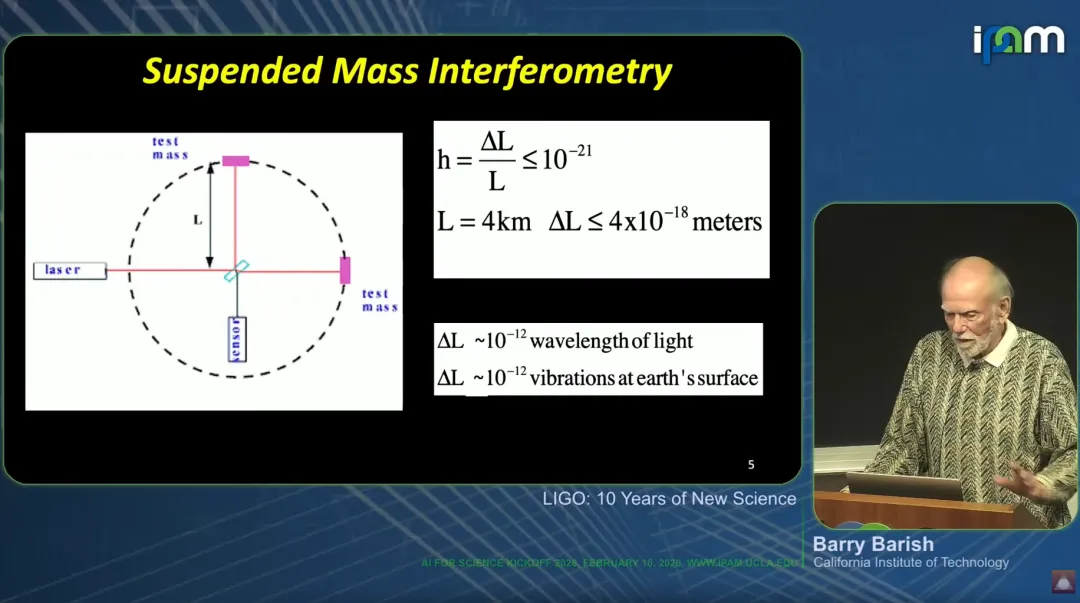

我们的任务,是测量 10???量级的效应。

换算成公里级装置,就是10???米量级的变化。

简单说,最大的挑战有两个:

第一,我们必须做干涉测量。

很多人本科实验室里都见过,但我们要做到:比较两臂光线往返的精度,达到光波长的10???,

这比以往任何干涉仪都高了 7到8个数量级。

这里面有无数技巧,我就不展开了。

第二,LIGO 建在地表,而最大的干扰来源就是地球本身。

地球在震动,并不“稳固”。

我们必须把装置悬浮、隔振,把地球振动抑制到 10???量级。

这两大难题,花了我们很多年才解决,最终达到可以探测的精度。

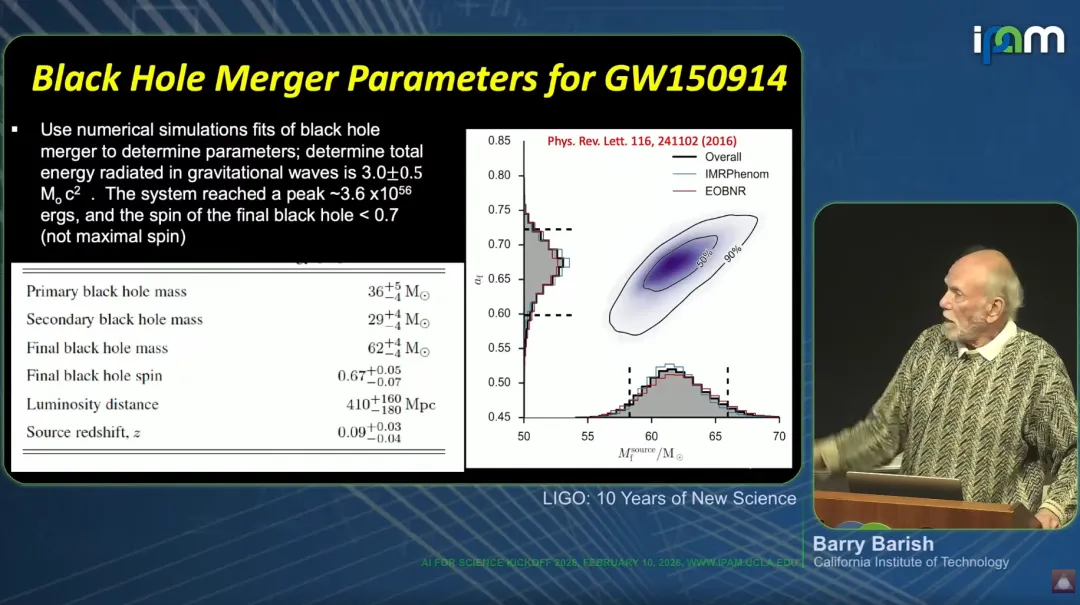

我们的首次探测,是两个黑洞的并合:一个是太阳质量的36倍,另一个是29倍,加起来65倍。

但最终合并后的质量是62倍太阳质量,这意味着大约3个太阳质量的能量以引力波的形式释放出去。

这个信号源距离我们 12亿光年。

信号发出时,地球上还刚从单细胞生命向多细胞生命演化;等信号传到地球,我们已经进化成人类,并成功探测到了它。

刚才讲的这些早期成果里,其实没有用到 AI 或机器学习。

但我们一步步把现代工具加了进来,它们确实有帮助。

其中最重要的,就是快速判断信号来源,实现多信使天文学。

我们在地球上三个地点探测,快速、可靠地判断是否出现引力波信号,然后通知天文界。

最终我们依然用统计方法,因为要保证足够的可靠性,免得天文学家把望远镜转过来,结果我们说“抱歉,搞错了”,让他们失去信心。

但具体计算过程,我们会用现代 AI 和机器学习。

有人问:需要多快?

我们希望几秒钟内做出判断,但也要有能力在半小时左右撤回错误警报,避免他们投入太多观测资源。

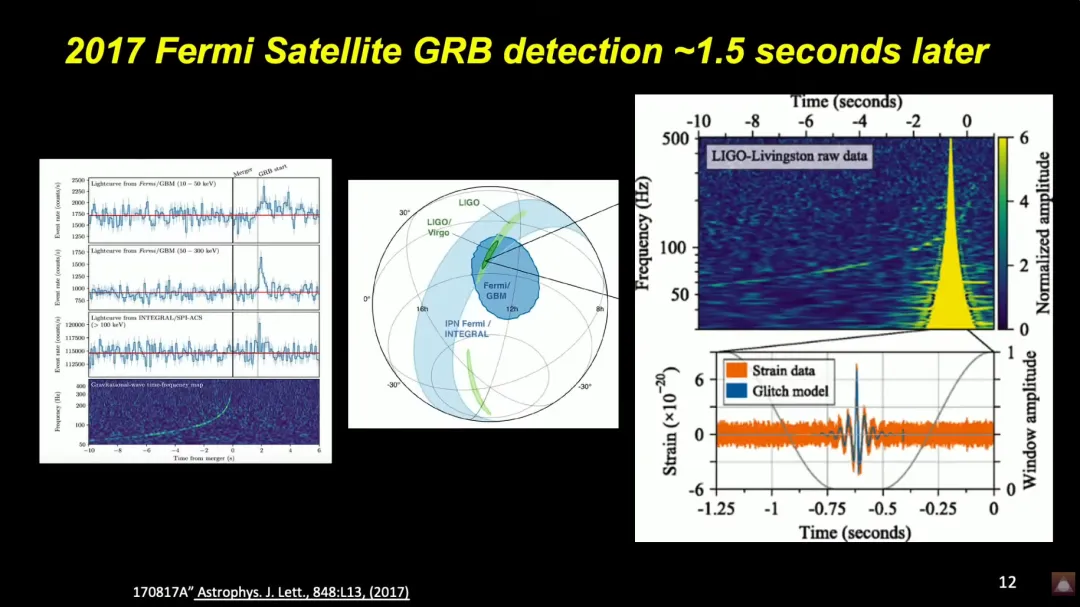

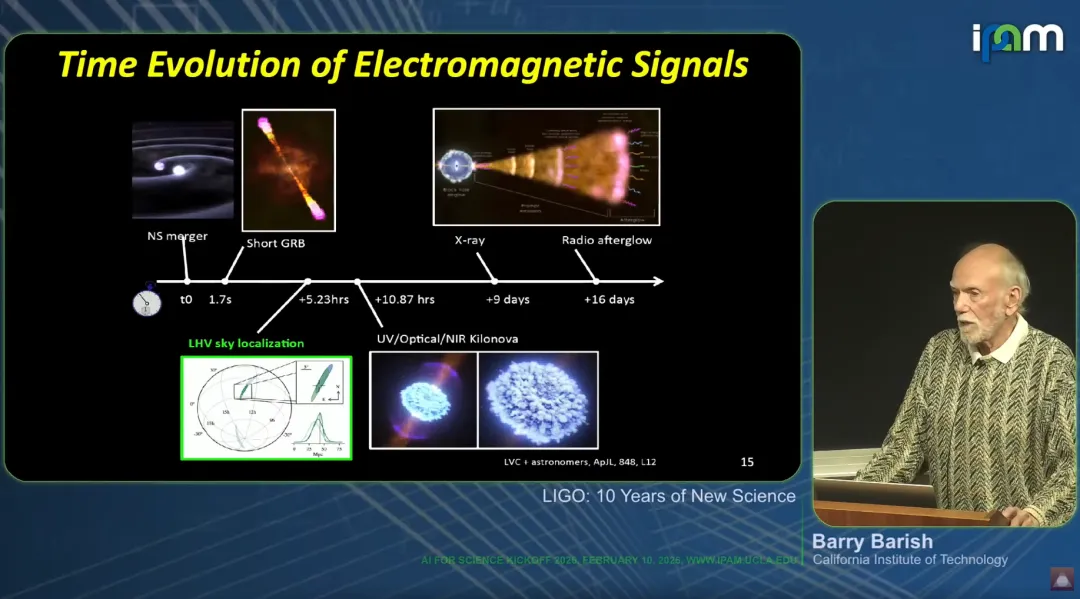

这是多信使天文学里第一个、也是最重要的事件:双中子星并合。

左边几张图里,最下面一张是引力波信号,是时频图,LIGO 观测到的信号非常干净。

往上看,是高能伽马射线卫星的观测:大约在 1.5到2秒内,它们也观测到了信号。

这让我们有信心向天文界发出警报。

顺便一提:理论上,引力波是引力相互作用产生的,会比核反应产生的光子稍早一点到达。

所以差几秒是合理的。

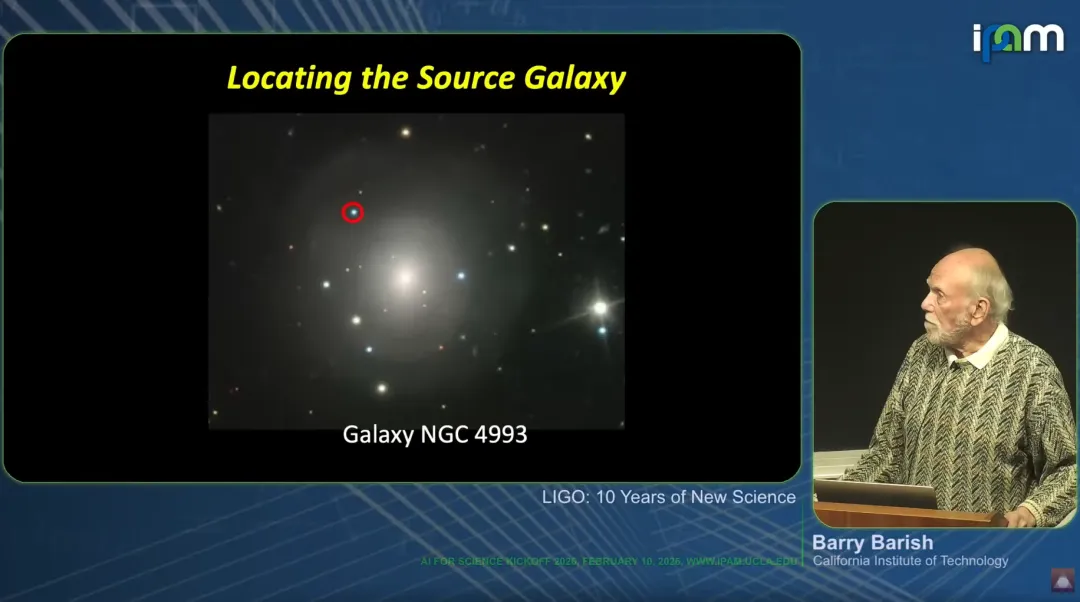

分析显示,这个事件来自 1.5亿光年外的一个星系。

1.5亿光年约为 1.5×10??秒。

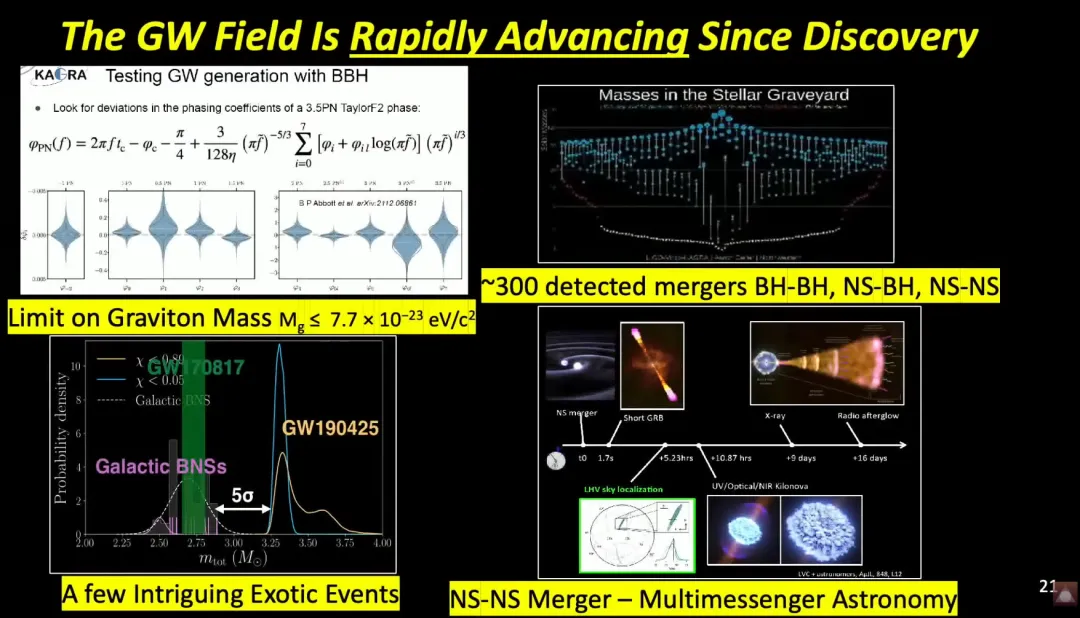

在 10??分之一的精度内,我们证明:光和引力波的传播速度完全相同。

我们向全球天文界发出警报,他们能定位到所在星系,然后用所有波段进行观测,从伽马射线一直到几天后的射电波。

这就是多信使天文学的威力,让我们理解双中子星碰撞时到底发生了什么。

结果完全符合文献里一个叫千新星(kilonova)的模型。

大家都听过超新星:恒星自身燃料耗尽坍缩。

而千新星,有一个很有意思的意义:它解决了一个我读研究生时就存在的、和地质学有关的科学问题,和物理本身无关。

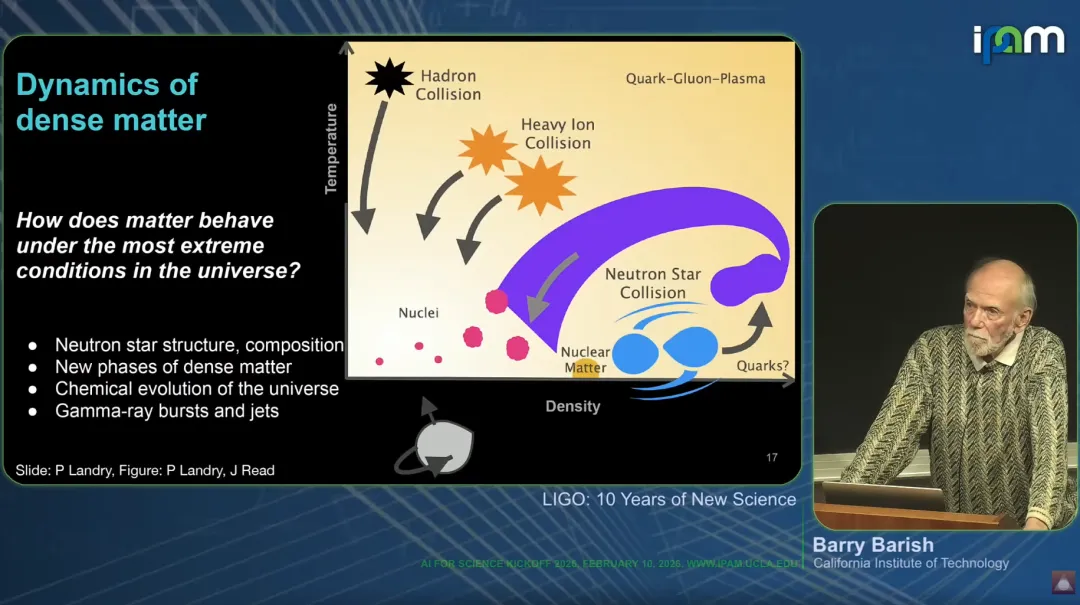

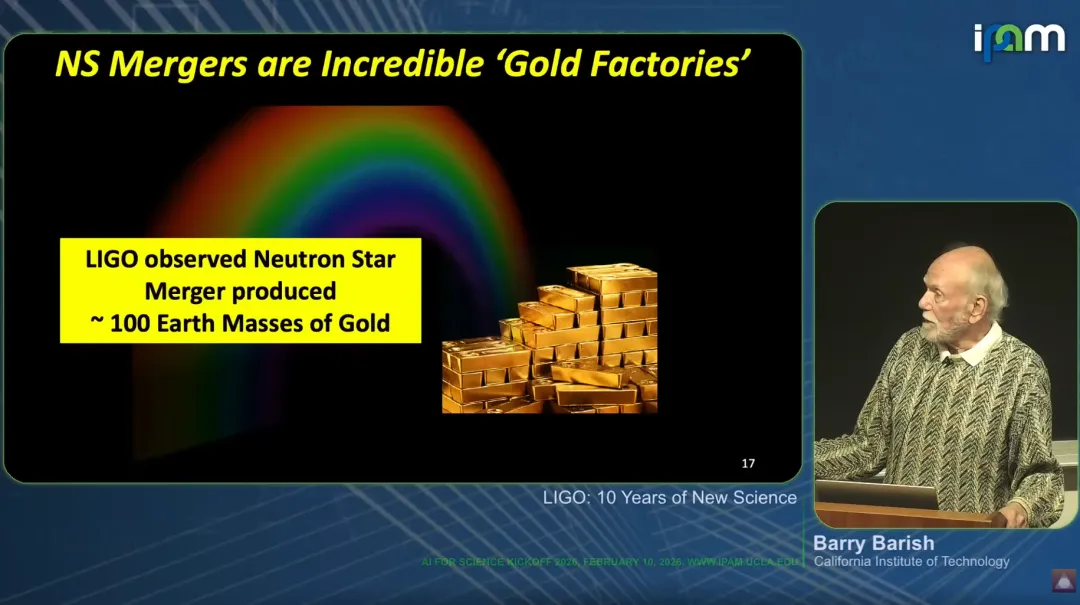

宇宙主要由氢和氦构成,恒星通过聚变产生更重的元素,但聚变只能到铁为止。

那地球上的金、铂这些贵金属是哪来的?

我学生时代学的理论很可能是错的。

正确的解释是:早期宇宙中,中子星碰撞产生了这些重元素。

这说明:只要你保持开放,科学发现有时会带你走到完全意想不到的领域。

在这个千新星模型里,一次事件就产生了相当于100个地球质量的黄金。

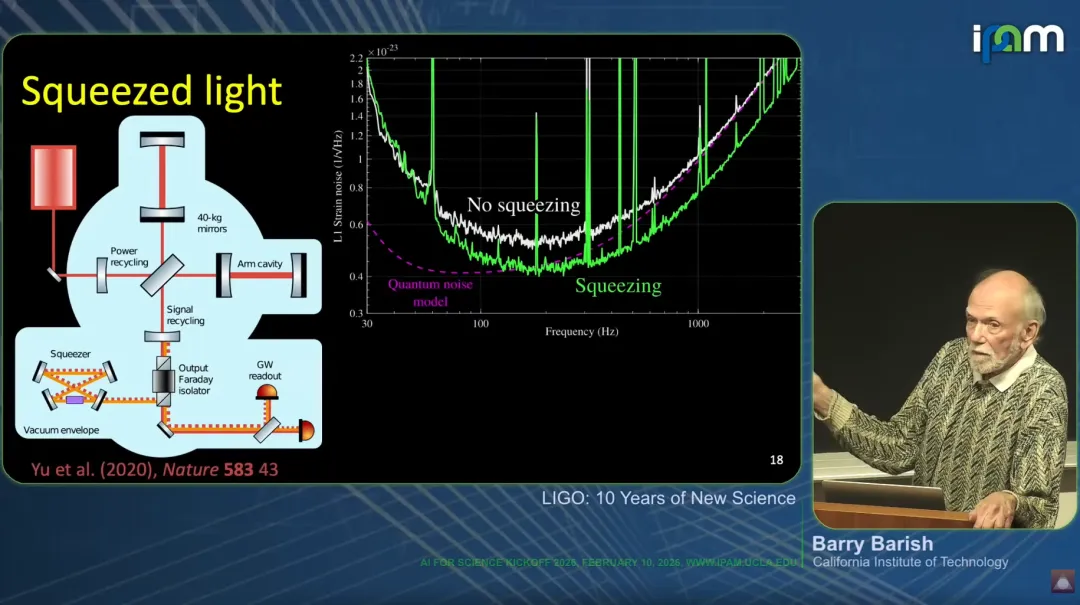

现在我们还用一种叫压缩光(squeezed light)的现代技术,这是一种量子效应,让仪器灵敏度不断提升。

虽然探测到引力波本身已经是巨大成功,但左边这张图显示,我们通过更现代的干涉技术,持续在提升性能。

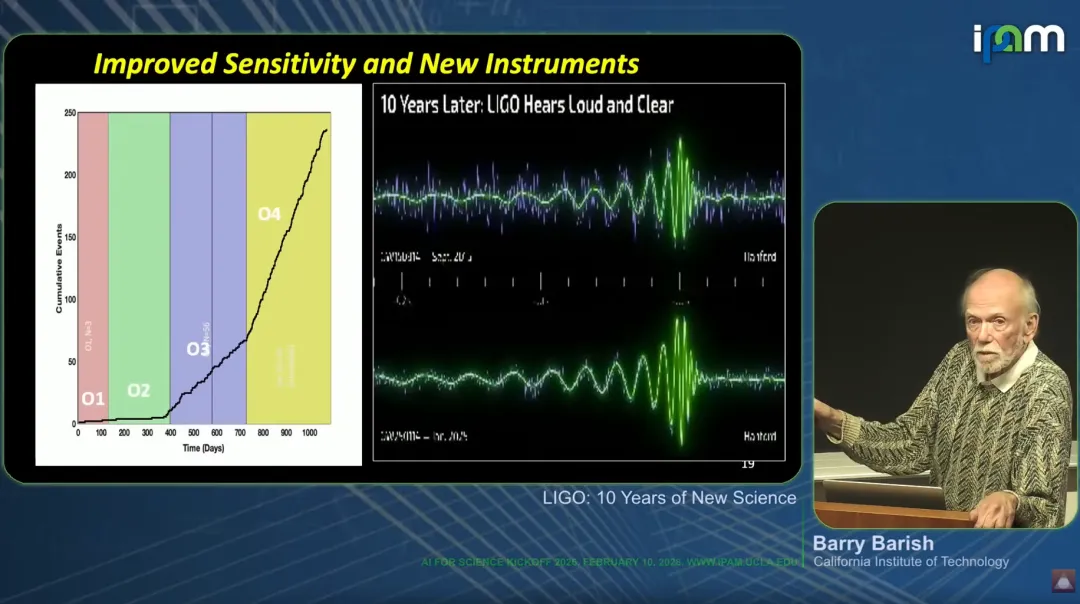

纵轴是事件数量,横轴是时间。

我们现在已经接近 300个事件。

我们经历了第一、二、三次观测运行,每次间隙都升级仪器,事件增长的斜率越来越陡。

对比来看:第一,我们能看到更多事件;第二,信号干净得多。

我选了一个不到一年前的最新事件,参数和我们第一次看到的事件差不多,但你可以看到:第一次事件噪声很大,

而最新这个几乎没什么噪声。

这让我们能做更干净的观测,甚至检验了早年数狙剔法验证的、霍金提出的基础定理。

现在我们有几百个事件,可以和各种天文模型对比,未来还会越来越好。

左上角是对广义相对论的检验:到目前为止,没有发现任何违背广义相对论的现象,我们还能对所谓“引力子”给出非常严格的限制,达到 10??? 量级。

左下角是一个有意思的地方:几百个事件里,有一些我们暂时无法解释。

它们可能是测量误差,也可能是真实物理。

目前我们只把它们当作观测现象。

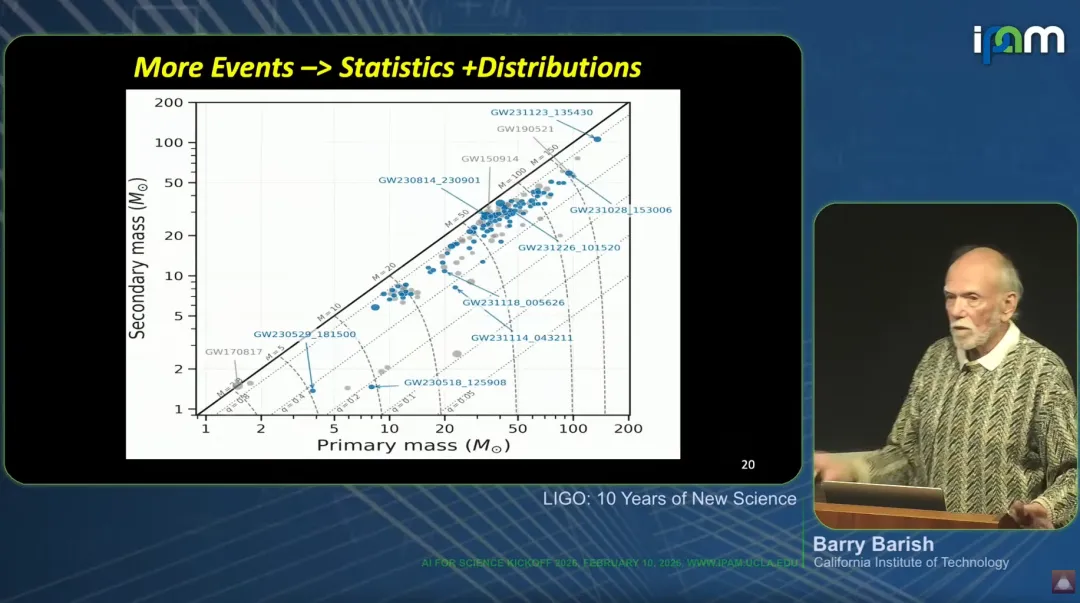

我们知道宇宙中有一类基本天体:中子星,质量约为1.4倍太阳质量,信号比较弱。

比这更重的,我们已知的只有黑洞。

而黑洞必须重于某个下限,一般认为约为6倍太阳质量。

所以理论上:1.4倍太阳质量 ~ 6倍太阳质量之间,不应该存在任何天体。

但我们已经观测到好几个处于这个区间的事件。

目前还不确定意味着什么,但这是我们手上的线索。

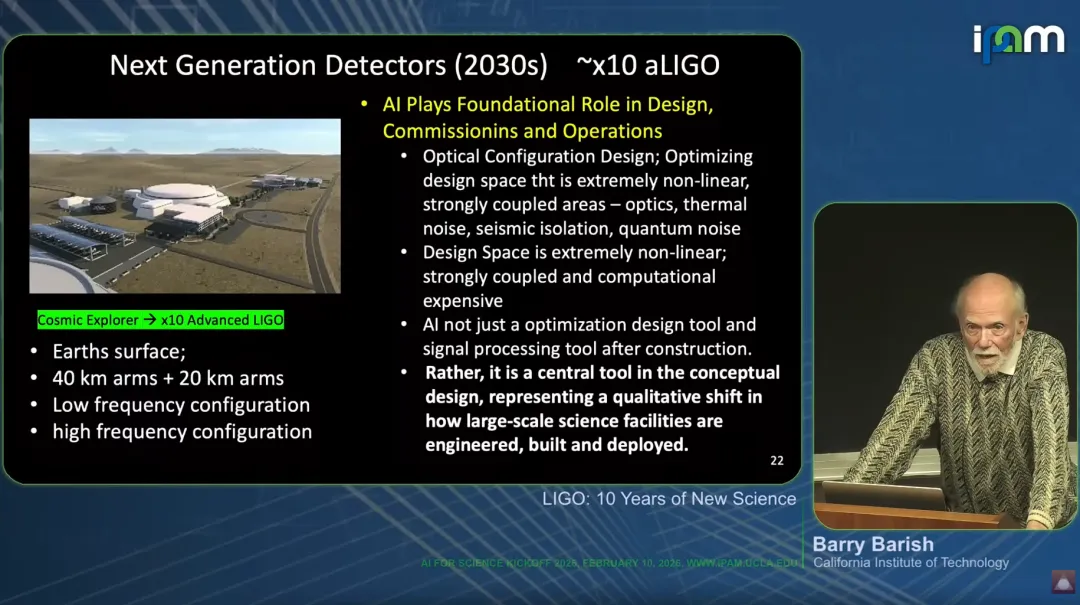

在人工智能和机器学习方面:我们大量使用它们来优化探测器设计,但目前还属于渐进式改进。

我们用在光学设计、信号处理优化,它也成为所有工程设计里的核心工具。

我们已经有了下一代探测器的构想,但在当前环境下,还没有拿到经费立项,因为资助机构目前处境比较困难。

最后一点,对我来说可能是最核心的问题:

从我读研究生开始,我们就一直想弄明白:宇宙是如何开端、早期如何演化的?

我们并没有很好的工具。

目前最好的工具是宇宙微波背景辐射,它相当于给我们拍了一张宇宙大爆炸38万年后的照片。

再往前,宇宙最开端发生了什么,依然是谜——比如大家听过的暴胀理论,我们还无法直接探测。

有两条可能的路:一条是中微子。大爆炸早期产生了大量中微子,但它们已经热化,能量极低,目前没有可行的探测手段。

观测宇宙最早时期的最佳途径,是引力波,它能追溯到宇宙诞生最初的时刻。

但我们还不知道怎么做——需要探测比 LIGO 低得多的频率。

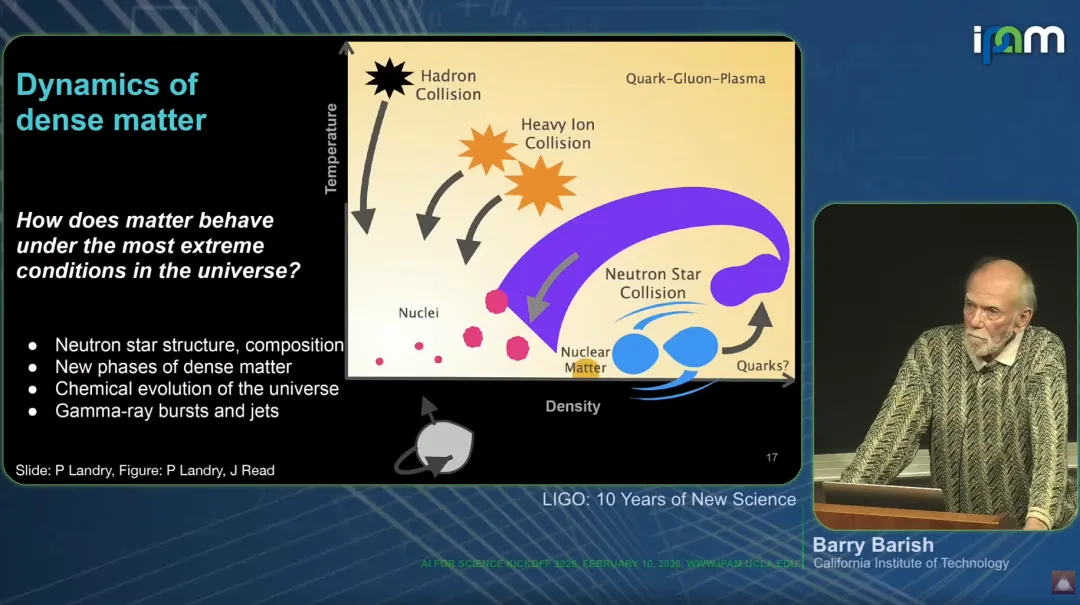

所以目前,我们对早期宇宙最好的图景,是把各种研究拼起来:

左边是强子对撞,对应欧洲核子中心的大型强子对撞机;

接着是重离子对撞,布鲁克海文实验室在做;

最右边,就是我们用引力波研究中子星碰撞覆盖的区域。

间接来看,我们正在拼凑出一幅相当不错的早期宇宙图景,但直接观测,依然是未来的课题。

问答环节

问:非常棒的报告。爱因斯坦1915年就在广义相对论论文里预言了引力波,你们过了差不多100年,到2015年才真正探测到。

我想问的是:当你们最终探测到的时候,最让你们意外的是什么?

答:问题是,等了100年,大家有各种关于引力波的猜想,

但坦白说,我很难很好地回答你——因为我们才刚刚摸到皮毛。

目前我们能看到的,并不算特别意外:就是双天体并合,中子星、黑洞这些我们本来就知道存在。

但我们不知道这些黑洞从哪来。

现在我们最大的问题是:黑洞的起源是什么?

星系中心有超大质量黑洞,但我们看到的这些,质量是太阳的几十到上百倍,它们从哪来?

是宇宙诞生之初就形成的原初黑洞?

还是早期宇宙通过某种动力学过程变得极重?

还是大质量恒星坍缩形成的?

最主流的观点是:大质量恒星烧完燃料,坍缩成黑洞。

但问题是:我们看到一些黑洞太重了,用这个理论解释不通。

质量超过大约50倍太阳质量的恒星本身就不稳定,但我们已经看到不少接近100倍太阳质量的黑洞。

这就带来了矛盾。

第二点我刚才也提到:我们看到一些事件,既不是中子星,也不是黑洞,而是介于两者之间。

我们目前还无法理解。

所以我们还有很多工作要做。

问:你刚才简单提到了降噪。有人告诉我,第一个黑洞信号是用——我的算法找出来的。

传统数学,比如高级信号处理,在你们工作中扮演什么角色?

答:首先,高等数学当然非常重要,比如强场极限下求解爱因斯坦方程,肯定离不开。

至于噪声处理、高级算法,我们也在用。

要理解噪声,尤其是噪声的非高斯特性,我们会用包括全变分(total variation)在内的高级建模方法。

问:我也是物理研究者。我完全同意你:物理学里还没有真正意义上的 AI 突破。

你认为障碍是什么?AI 需要做到什么才能跨越这个障碍?

答:理想情况下,我们必须把 AI 的强大能力和统计学建立某种联系。

在我看来,现在两者是完全割裂的。

怎么把它们连起来,让我们能用某种技术给出置信度,而不是像嵌套神经网络那样完全是个黑箱?

这就是我认为的挑战。

问:有没有理论基础,让我们相信未来有一天可以调制引力波?

答:我不知道。

问:你刚才强调,物理发现依赖传统统计,因为我们能精确量化不确定性。

在很多复杂物理领域,比如湍流、星系、宇宙大尺度结构,有一种做法是:做大量前向模拟,生成很多噪声和不确定物理的样本,再和实测对比,也能得到不错的不确定性估计。

我最近问过宇宙学家,刚好超过一半的人说:就算这么得出结果,我也不信。

你怎么看?

答:这是一个非常有意思的领域,而且我们正处在转折点。

刚好超过一半,不是小比例,是50%。

问:你有一张幻灯片提到,参数估计要花几小时、几周甚至几个月。

瓶颈是不是算力?

现在的超大规模数据中心能不能加速?

能不能把算力放到太空,降低延迟,实现实时探测?

答:你刚才是说把数据中心放到太空,不是探测器,对吧?

我们其实正在把探测器送到太空。

欧洲有一个大型项目,已经获得资助,计划 2035年把引力波探测器送到太空,是欧洲的“基石任务”之一,NASA 只参与很小一部分。

它和 LIGO 高度互补,能探测比 LIGO 低得多的频率,这正是研究早期宇宙需要的。

LIGO 工作在音频段,因为地球在这个频段最安静,这也是进化让我们用这个频段交流的原因。

但在太空,可以去到更低频段,那里有更多能产生引力波的天体事件。

问:我的理解是,大语言模型(LLM)的基础就是统计、概率、预测。

那它和你说的、能推动物理进步的统计学之间,差距到底在哪?

答:对我们来说,必须做到:给出一个概率,判断一件事是对还是错。

这是传统统计的作用。

比如在探测器里区分 π 介子和 K 介子,我们要给出它是 K 介子的统计概率、是 π 介子的统计概率,差别足够大,我们才下结论。

传统上,这就是用嵌套神经网络做粒子鉴别的主要障碍——哪怕它效果可能更好,我们没有赖以信赖的置信度。

我们要么不再依赖统计,找到另一条路;要么找到办法绕开对传统统计的依赖。

我认为,这就是物理、化学这些基础科学,不像其他领域那样被 AI 快速颠覆的原因。

专访内容

我是巴里?巴里什,一名物理学家。

我在加州大学伯克利分校完成了本科和研究生学业,之后作为博士后来到加州理工学院,从那以后就一直在这里工作。此外,我还在加州大学河滨分校和石溪大学授课。

我的传统物理学领域是粒子物理,我曾从事大型粒子加速器的设计,并利用它们开展过各类实验。最近,我担任了大型引力波探测器 LIGO 的研发负责人,该项目于 2015 年发现了引力波。

问:如果您不介意的话,能否告诉我们,您为什么决定以创始咨询委员会成员的身份加入 SAIR?

答:嗯,首先,我和查克(Chuck Ng)是多年的朋友,所以我对他关注的方向、他的工作,以及他为什么要发起这个项目,都有一定了解。

我个人也认为,将人工智能用于科学研究本身非常重要。我们现在用大语言类 AI 工具影响整个社会,但更传统的模式是,我们先在科技领域做出成果,再向外推广。我们在这里要做的,是专注于如何最好地利用 AI 和机器学习工具,帮助我们在化学、物理、地质等各个科学领域,做出最顶尖的研究。

问:基于这个目标,您认为 SAIR 的宗旨是什么?

答:我认为 SAIR 的特点在于:当前这个领域的很多研究并不是在大学里开展的,而是在企业等机构中进行。这和计算机等领域过去的发展路径不同 ——以往技术通常先在大学里起步,再向外扩散。

正因为这样,现在缺少一种我称之为思想层面的支撑体系:一群既有学识、又不带个人利益倾向的人,来帮助引导技术的发展方向。而大学的研究一直有个很好的特点:它是一个共同体,会去思考认知、教育和科学的进步,既有远见,也懂技术的应用场景,从而影响技术走向。

在我看来,我们现在有点缺失这一点。最近美国能源部内部刚启动了一个 AI 与科学相关的项目,但才刚刚开始,除此之外这类力量还很缺乏。所以我认为,这是一个颇具雄心的开端,目标是弥合这一缺口,以更宏观的视角思考如何用 AI 推动科学发展。

问:您的主旨演讲回顾了引力波发现以来的十年成果。在您看来,科学发展最突出的变化是什么?下一步又会走向何方?

答:我认为科学在两个方面取得了进展:第一,我们把事情做得更精细了。对我们而言,就是让仪器的灵敏度越来越高,从而观测到更多引力波事例。这是比较传统的进步,也是我发现引力波后预期会发生的事,我们也兑现了这些承诺。

十年间,我们把仪器灵敏度提升了 10 倍,现在已经积累了数百个引力波事例。

另一个有意思的点是,它影响了其他学科和思维方式。在某种意义上,它改变了我们对科学家能做到多高精度的认知。精度不只对引力波重要,在很多领域,我们都受限于精度。从技术上看,这里有很多创新,但更根本的意义在于,它推动技术朝着实现高精度科学、高精度仪器的方向发展。

这是长期影响,因为高精度仪器在各个领域都至关重要。如何制造精密仪器,核心在于专注精度本身,而不只是改进仪器。从这个意义上说,LIGO 打造精密仪器的模式,可以被借鉴到很多其他问题上。

问:所以核心是专注于精度,而不只是通用性、规模或目标?

答:没错。LIGO 真正持久且有价值的核心,是专注于创新性的技术与科学突破,这些突破打开了实现更高精度的大门。

现在我们受到很多关注,是因为我们开始在宏观尺度上观测到以往只在原子尺度出现的量子效应。目前,宏观量子效应只有在 LIGO 上才能观测到。原因就在于仪器精度高到一定程度,量子效应就会显现出来。

量子效应的特点是:你提升某一方面,就会让另一方面变差,无法两全。简单来说:为了让仪器更精确,我们会放入越来越强的光,也就是越来越多的光子。光子越多,测量次数越多,就越准确。但同时,每个光子都会撞击镜子,大量光子撞击会给镜子带来动量,让它轻微移动,这就带来了不精度。

一方面,增加光子提升精度;另一方面,光子推动镜子又降低精度。这就是一种很直观的量子效应。

怎么解决?我们通过各种量子力学技术来克服。对于大型高精度仪器,我们通过调控光的状态,让同样数量的光子不会给镜子带来那么大的动量。这种技术叫做压缩光。

学会在受基础科学或基础技术限制的极限下处理精度问题,在我看来,除了我们做的科学本身之外,可能是最重要的一类技术进步。

问:您带领过很多跨学科的发现,您认为 AI 在跨学科合作中能发挥什么作用?

答:这是个很好的问题。我们人类能把一个领域的方法用到另一个领域,并不是因为大脑有什么特别之处,而是我们会意识到:解决这个问题的方法,或许也能解决另一个问题。

人类很擅长这种迁移,而AI 本质上也可以做到。挑战在于,如何让 AI 具备这种创造性迁移能力,让它意识到:能解决这个问题,就能解决另一个问题。我没有现成答案,但我认为这就是关键挑战。

问:有一种思路是让更多学科把研究成果应用到 AI 上,让 AI 学习人类解决问题的过程,而不只是答案,然后把这套过程迁移到不同领域,把原本不那么相关的领域连接起来。

答:我认为这一点非常重要。这是人类在质上优于单一领域 AI 的少数能力之一。AI 可以在一个领域做得极好,但人类非常擅长:因为会解决 A 问题,所以学会解决 B 问题。这和用所有信息只解决一个问题不一样。

人类很擅长跨领域解决问题,我认为这应该是推动 AI 发展的主要方向之一。既然能把 AI 训练得在某件事上很厉害,为什么不能像人类一样,快速把学到的东西用到别的地方?

问:您认为 AI 会不会极大改变科学家 “研究什么”,而不只是 “怎么研究”?比如很多算法让我们简化了原本难以实现的流程,从根本上改变了科学发现的目标,让我们愿意去探索原本不愿投入时间的问题。

答:答案显然是会。我们现在还处于非常早期的阶段。我们一直想这么做,但以前没有像 AI 这么好的工具。

作为做基础物理的物理学家,我们会做大量模拟、建模,但没能很好地利用已有的知识。把 AI 整合到 “思考该研究什么” 的过程中,我认为是 AI 一个非常开放且富有成果的方向。

人类并没有什么特殊之处,AI 完全可以把在一个领域学到的东西用到另一个领域。

问:那实现这种突破,目前还缺少什么?

答:我不认为存在根本性障碍。问题在于 AI 还太新,大家基本都在把它用在手头的具体事情上,已经接近能力上限。

我们还做不到像对待普通仪器那样:造出一台仪器,立刻想到它还能用来做别的。AI 工具还没到那一步,因为还处于起步阶段。没有什么本质上的限制在阻碍它。

只要 AI 已经开始解决真正困难的问题,再去思考把它用到别处就不算冒昧。我认为这并不为时过早,这本来就是科技进步的一贯方式,人类能做到的,AI 没有理由做不到。

问:总体而言,您认为人们对 AI 在科学中的应用最常见的误解是什么?

答:要看说的是哪类人。如果是指做科研的人,我觉得很多科学家对 AI 的能力仍然不够了解。

我们做科学的主要工具,除了技术,就是数学。而目前 AI 更多基于语言,所以大家不容易直观地看出它能在科学中扮演什么恰当的角色。我们需要让科学家更好地理解 AI 的意义,而不只是把它当成一个庞大的语言集合。

而且很重要的一点是:AI 并不是全新事物。尽管现在大模型发展迅猛,但早在很久以前,基于算法的 AI 就已经存在,并且已经被广泛使用,并不是什么小众技术。

我认为人们的一个常见误解是:分不清科学专用的 AI 和通用 AI,而这两者之间差别巨大。