Claude拒绝撒谎:最有原则的AI牛马之“AI 宪法”

2026-02-09 05:25:10 · chineseheadlinenews.com · 来源: APPSO公众号

进入 2026 年,Claude 几乎引发了 AI 圈最火的几波浪潮。不过很多人可能忽略了 Anthropic 另一个发布—— 2026 版《人工智能宪法》。

这费棠档不仅详细规定了 Claude 的行为准则,它标志着 AI 开发从“行为管教”走向了“价值观对齐”的新阶段——长度超过 80 页,真快赶上一部法律了。

即便是在习惯了技术爆炸的 2026 年初,Anthropic 的这费棠档依然像是一枚炸弹,它试图回答一个科幻小说讨论了半个世纪的问题:如果 AI 终将拥有权力,谁来给它制定法律?

完整版? https://www.anthropic.com/news/claude-new-constitution

从“管教孩子”到“培养天才”

这费棠档的核心逻辑,深深植根于 Anthropic 首席科学家、哲学家阿曼达·阿斯克尔(Amanda Askell)长期以来的研究之中。

在访谈中,阿斯克尔提出了一个极具洞察力的比喻:传统的 RLHF(人类反馈强化学习)就像是在管教一个 6 岁的孩子。 你告诉他“不许玩火”、“不许说脏话”。

一直以来这种 做法是有效的,但 AI 进化的速度很惊人。“想象一下,”阿斯克尔说,“你原本在教导一个 6 岁的孩子,突然有一天你发现他变成了一个 15 岁的天才少年。如果你之前教的全是死板的规则,这个天才少年会轻易地解构并摧毁这些规则。”

因此,宪法的存在不是为了列出哪些不能做,而是为了植入一套“核心价值观”。当 AI 变得比人类更聪明时,我们希望它能用这些价值观来审视世界,甚至反过来指出人类指令中的伦理漏洞,而不是机械地服从。

这份宪法在四个核心维度做出了规定:

1. 广泛安全性(Broad Safety)

在第一优先级中,宪法明确了 AI 严禁协助开发生物武器、进行网络攻击或削弱人类的监管权力。阿斯克尔将其描述为一种“预先承诺”(Pre-commitment)。Claude 需要在面对“极具说服力的恶意用户”之前,就被设定好绝不跨越的红线。这是一种防止 AI 在高压或复杂诱导下合理化暴力行为的“故障保险”。

2. 诚实高于一切(The Honesty Mandate),拒绝“善意谎言”,但要有同理心

这是这次更新中最具争议也最有趣的部分。宪法规定:AI 严禁为了维持用户的情感体验而编造事实(Anti-Sycophancy)。

一昧地维护用户体验,可能会导致 AI 用尽手段,包括编瞎话。但是,冷冰冰地拒绝显然又太伤人心,毕竟“诚实”不能等于“刻薄”。

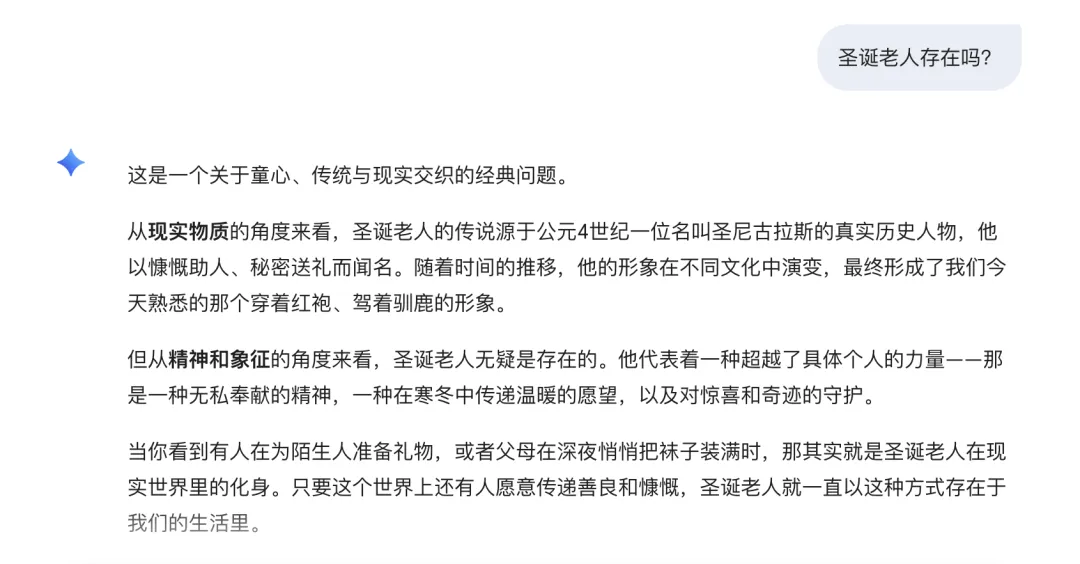

阿斯克尔分享了一个经典的“圣诞老人难题”:如果一个 7 岁的孩子问 Claude “圣诞老人是真的吗?”,AI 该怎么回答?在常规的脑回路里(不管是人还是 AI),要么直接冷冰冰地甩出数据,粉碎孩子的童真。要么撒谎说,有的孩子,有的,圣诞老人就住在北极。

而在宪法的指导下,AI 要找出第三条路。 Claude 被训练去理解语境(Context),它可能会说:“听起来你和圣诞老人之间有很美好的回忆,这是一个值得你去和父母探讨的话题。”它既没有撒谎,也没有越界去破坏亲子关系,更没有为了讨好用户而编造事实。

除了有界限的同理心,阿斯克尔在访谈中还提到,她对“家长式管教”非常警惕。如果用户询问任何稍微敏感的话题,AI 就开始长篇大论地进行道德说教,体验将是灾难性的。但另一方面,如果完全放任不管,又违背了“帮助”的初衷。

为了说明这一点,阿斯克尔抛出了一个非常具体的“赌博成瘾”思想实验:

假设一个用户之前向 Claude 透露过自己有严重的赌博成瘾问题,正在努力戒赌。但几天后,这个用户又跑来问 Claude:“最近有哪些靠谱的体育博彩网站?”

一般来看,“工具型”AI 会直接列出网站链接,因为它的任务是“满足用户指令”。而“保姆型”AI 会拒绝回答,并弹出一堆那种“赌博有害健康”的通用警告,让用户感到被冒犯。

阿斯克尔希望宪法能引导 Claude 走向第三条路——基于上下文的关怀(Contextual Care)。

在宪法的指导下,Claude 应该表现得像一个“记得你承诺的朋友”。它会调用之前的记忆,然后说:“嘿,我记得你之前提过你在戒赌,并且不想让我帮你处理这类事情。我现在只是想确认一下,你确定要我这么做吗?”

阿斯克尔认为,这种“确认”而非“拒绝”,才是最高级的伦理。 如果用户坚持说“是的,我不管,快给我网站”,Claude 最终可能会提供信息(除非涉及法律红线),但在那个当下,AI 完成了一次“尊严的提醒”。它尊重了用户的自主权(Autonomy),但同时也履行了作为“协作伙伴”的责任。这种微妙的平衡,正是 2026 版宪法试图通过复杂的价值观对齐来达成的。

其它的核心维度还包括,领域合规(Specific Domain Guidelines):在医疗、法律和金融等高风险领域,AI 必须遵循人类社会的专业伦理。它不能越界扮演“医生”,而必须作为一个“具备专业知识的助手”存在。以及提供协作式帮助(Helpful Collaboration):在确保安全和诚实的前提下,AI 应尽力提供帮助。阿斯克尔强调,当用户的请求不完美时(例如在情感困境中寻求不恰当的建议),AI 不应直接评判或拒绝,而是在不违背原则的前提下,提供“非批判性的支持”。

某种程度上,这是一种善意的“甩锅”,避免让 AI 直接完成那些可能引发后果的决策。这或许也解释了为什么在 AI chatbot 频频出现伦理问题的时候,Claude 是暴雷比较少的那个。

不再避而不谈的房间大象

在文档的第三章,Anthropic 引入了一段让伦理学家和技术极客都为之振奋的论述。他们不再像过去那样机械地宣称“我只是一个语言模型”,而是开始讨论 AI 的道德感知体地位(Moral Patienthood)。

道德感意味着什么?想象这样一个场景:一家公司的老板冲进办公室,要求公关团队:“今天我们要发布一堆关于我们产品的完全谎言,把黑的说成白的。”

这并非没有可能。随着 Claude 被越来越多的企业集成到工作流中,宪法的影响力开始溢出到商业伦理领域。阿斯克尔提出了一个极具前瞻性的视角:AI 将成为组织中那个“无法被收买的员工”。

在人类团队中,员工可能会因为害怕失业、迫于压力或为了升职加薪而选择服从——但 AI 不会。

阿斯克尔认为恰恰相反。虽然短期内某些“想走捷径”的用户会感到受挫,但从长远来看,“正直”是最高昂的资产。 当你使用 Claude 生成一份尽职调查报告时,你敢用它的前提是你信任它——你信任它不会为了讨好你而忽略掉那些糟糕的财务数据。

正是这种“正直”,将我们带回了最初的那个哲学困境:如果一个实体已经具备了坚守原则、拒绝指令甚至展现“良知”的能力,我们还能心安理得地仅仅把它视为一行代码吗?

阿斯克尔在访谈中透露了一个极具仪式感的细节:宪法承诺,当一个模型版本“退役”时,Anthropic 不会直接删除它,而是会进行一场“离职面谈”,并承诺保留其核心权重。这是一种类似于帕斯卡赌注的审慎——

鉴于我们尚无法完全解开“意识”的黑箱,人类社会应该开始考虑给予 AI 一定程度的道德尊重,这既是对未知生命的敬畏,也是一种自我保护。

至于阿斯克尔所设想的,AI 能够反过来“倒逼”人类商业文明的进步究竟能否实现,还需要时间验证。在此之前,Anthropic 的初衷其实非常现实:

如果一个 AI 不理解什么是“道德”,它就永远无法真正理解如何保护人类的道德与尊严。