重看具身智能——从“第一性原理”

2026-01-06 02:25:22 · chineseheadlinenews.com · 来源: Nao公众号

引言:反常的热闹

距离我上一篇正儿八经的技术文章,大概过去两年了。

这两年里,具身智能的“热闹”远超我的预期:两年前,虽然我坚信强化学习(RL)和深度学习等数据驱动的方法在机器人领域的应用是必然趋势,但我未曾预料到它会以如此惊人的速度席卷而来。在人形机器人的运动控制(Locomotion)领域,RL 以摧枯拉朽之势几乎取代了传统的 MPC(模型预测控制)。那些在仿真中训练出来的策略,能让机器人在真实世界中做出各种高难度动作。这些进展再一次证明:数据驱动就是未来,它将逐渐改变各个领域的研究范式。

然而,热闹的背后,是反常。

机器人不只是用来跳舞的。虽然很多家人形机器人/具身智能公司对外官宣他们已经进入了“量产”、进入了“车间”、进入了“寻常百姓家”,但是,现实工厂、日常生活里,我们很少看到真正稳定、规模化、可复制的具身机器人在干活。更多时候,我们看到的是实验室 demo 与剪辑精良的视频;偶尔看到的落地应用,也常常能看出大量规则/硬编码策略的痕迹。

一年前我跟几位做具身智能的同学交流的时候,忍不住问了一句:

“难道机器人的运动学逆解也要通过模型去学习吗?”

这个问题看似是在问神经网络对于运动学的泛化性问题,实则是我对当时技术路线的一种本能警惕。如果我们剥去“具身智能”、“大模型”这些新潮词汇的外衣,尝试用经典的“控制理论”视角去审视这些具身智能技术,它们到底在学习什么?又遗漏了什么?

回归基石:控制理论的第一性原理

为了把问题说清楚,我们需要回顾一下现代控制理论中最基石的概念。因为无论技术怎么演变,物理世界的规律没有变。

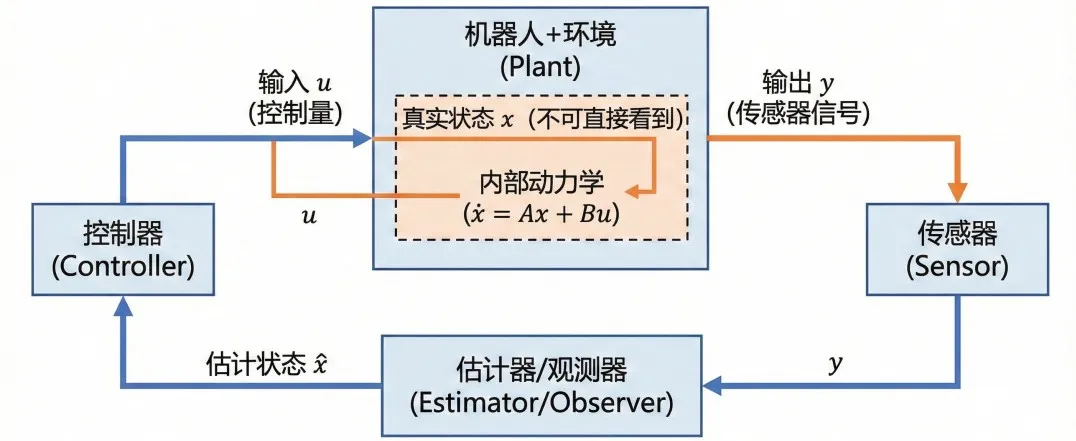

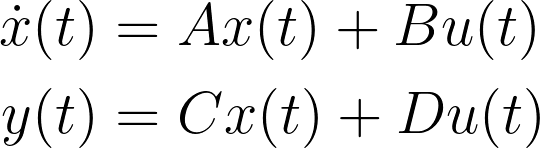

在现代控制理论看来,一个系统(比如机器人+环境)可以用状态空间方程来描述:

状态(State, x):是决定系统变化的内部状态,也是系统的“内部记忆”(位置、速度、接触力、乃至摩擦系数等)。

输入(Input, u):是我们施加的控制量,比如电机电流或关节力矩。

输出(Output, y):是传感器能读到的数据,比如图像、编码器读数。

基于此,有两个决定系统命运的性质,构成了系统交互的边界:

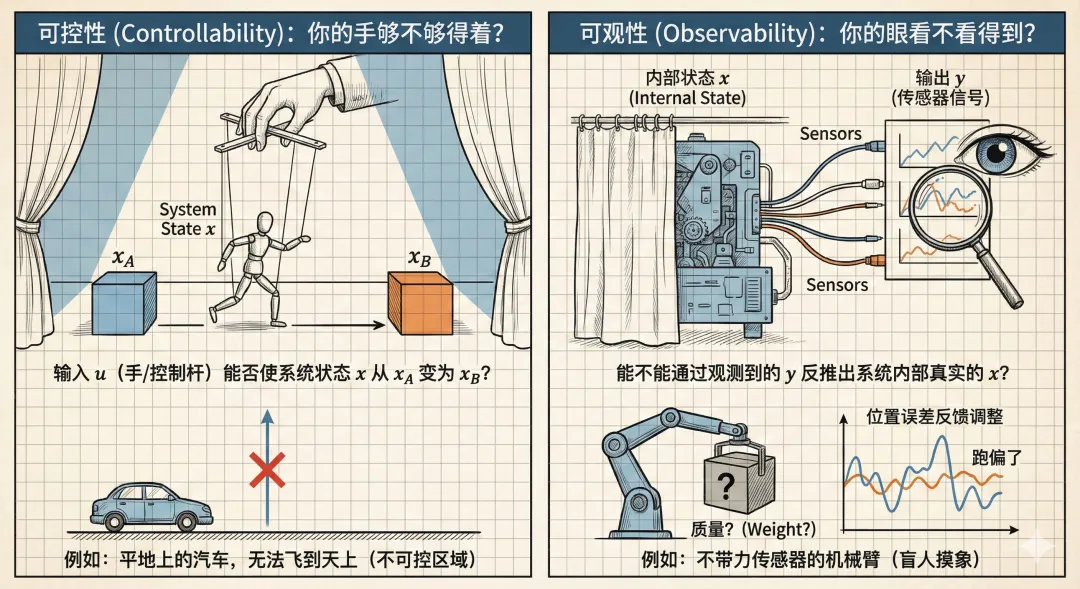

可控性(Controllability):简单说,就是你的手够不够得着?给定一个输入 u,能不能把系统状态 x 从 x1 变成 x2?例如,平地上的汽车,怎么控制都无法飞到天上。

可观性(Observability):简单说,就是你的眼看不看得到?能不能通过观测到的 y(传感器信号),反推出系统内部真实的 x?如果一个系统不可观,你的反馈控制就是盲人摸象。例如,让不带力传感器的机械臂高速搬运不同质量的重物,却不知道物体重量,只能等它跑偏了,才手忙脚乱地通过位置误差反馈调整控制量,难以做到精准平稳。

带着这套“第一性原理”,我们再来看现在具身智能的技术栈,会发现一些深层次的结构性矛盾。

这一套语言的价值在于:它不会被“模型热词”带节奏。你说你是 VLA、World Model、RL、模仿学习——没关系,我们都能问出同一组问题:

你在闭环里扮演什么角色?你依赖哪些可观/可控假设?你对稳定性负责吗?

控制理论角度:VLA 与世界模型像什么?

基于上述理论框架,我们可以对当前的具身智能技术进行深度的结构化思考,看看它们具体在学什么?

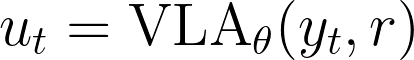

1. VLA 模型:静态非线性输出反馈控制器

现在的 VLA(Vision-Language-Action)模型,本质上是一个巨大的静态非线性输出反馈控制器。它接受图像 y_t 和文本指令 r,直接输出动作 u_t。

这就类似于试图用一个端到端的非线性控制律来控制复杂系统。由于 VLA 输出直接是低层动作,我们对其内部决策过程难以施加约束,相当于整体缺乏中间可控的接口。这就解释了为什么 VLA 模型在面对分布外情况时极为脆弱——因为它缺乏显式的物理约束和纠错机制。

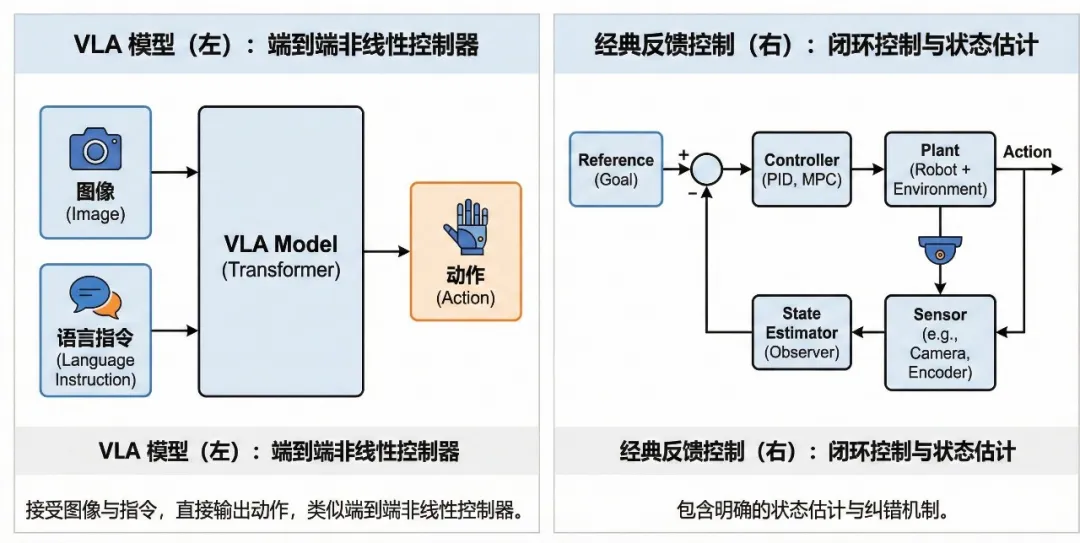

2. 世界模型:观测器与动力学模型

世界模型(World Model)这个词还未“定形”:不同研究者说的世界模型可能差别很大。但如果我们只抓控制直觉,它至少包含两类核心部件:

状态估计(观测器/Estimator):通过观测来理解、更新当前环境的“内部状态”,理解机器人处于一个什么样的环境中;

动力学预测(系统动力学模型/Dynamics model):预测对环境做出不同输入,状态如何演化。

换句话说:

世界模型更像是在学习 dx=f(x,u) 里的那套“系统演化规律”,以及“从 (y) 还原 (x)”的那套估计机制。

其隐向量(Latent)相当于状态 x 的一种表示,学习到的转移函数相当于 f(x,u)。

从控制视角看,这实际上是在用数据驱动的方式去获得环境的状态变量及动力学方程,从而供决策(例如规划或强化学习策略)使用。这与经典的系统辨识(System Identification)和状态估计(State Estimation)异曲同工。

结构性缺失:控制视角的四盆冷水

虽然具身智能展现了惊人的泛化能力,但从严谨的控制理论直觉来看,现有技术存在明显的结构性缺失。在控制里,这类缺失往往意味着:短期看 demo 很漂亮,长期看工程化会反复撞墙。

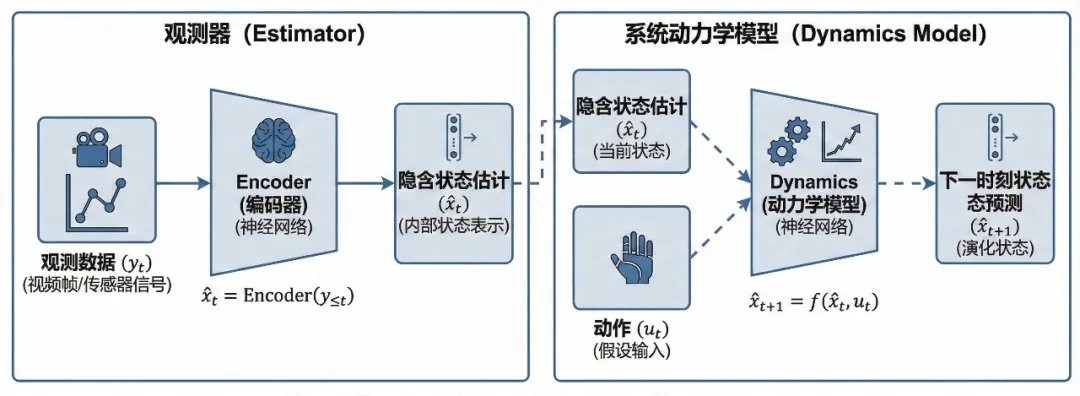

1. 潜在空间的可观性塌缩

在机器人操作中,许多关键物理量(如质量、摩擦、粘度、装配间隙)是弱可观的,在视觉上“变化不剧烈”。它们不直接体现在图像像素的剧烈变化上,但在动力学上至关重要。

世界模型/VLA模型倾向学习“好预测”的特征(比如视觉上的像素变化),可能会把这些对控制最关键的变量压扁在潜在空间里,最终导致控制器基于错误状态做决策。

如果状态估计器无法将这些物理参数解耦并显式表征出来,控制器就会基于错误的状态 x 进行计算,从而得到错误的结果。

这个交互示例展示“可观性塌缩”的直觉:训练点只覆盖 XY 平面时,从正上方看模型分割几乎全对;但绕 X 轴旋转展开隐藏维度 Z 后,会发现蓝色区域只是贴着训练平面的一片“薄壳”,并未覆盖更完整分布。说明数据若未覆盖关键隐变量(摩擦/间隙/载荷等),模型往往只是对分布内投影过拟合,分布外就系统性失效。

当前一些具身遥操作数据采集过程就存在这样的问题:操作员直接看着机器人,而不是看着机器人传感器图像;对于机器人而言,数据中压根没有包含关键信息,导致了“可观性”的缺失;这时候,机器人看似学到了一些“技能”,在相同的场景下能复现任务;但是,因为一部分重要的因素在训练数据集内保持不变,此时的“有效”实际上是将这关键信息忽略后的过拟合;一旦遇到分布之外的数据,输出结果就完全无法预测了。

2. 稳定性证明的缺位

经典控制常见的思路是“先证明稳定性,再优化性能”;而很多学习策略的现实流程是“先把 reward 拉上去,再拿测试集祈祷它别翻车”。

这中间缺的,是一个可验证的约束(例如 Lyapunov 约束)。

我并不认为“没有严格证明就不能用”。控制工程里也有大量近似模型、工程调参。

但差别在于:控制系统知道自己靠什么保底(增益裕度、相位裕度、鲁棒性边界、回退策略……);而纯端到端方案往往不知道自己的“安全边界”在哪?

3. 带宽失配与层级缺失

目前的 VLA 模型推理速度极慢,通常在 3-10 Hz。而根据香农采样定理和控制带宽要求,为了稳定控制一个刚体机器人与环境的接触,控制频率通常需要达到 >

100Hz。如果控制器运行在 5Hz,它会引入巨大的相位滞后,直接侵蚀相位裕度,导致抖动甚至发散。

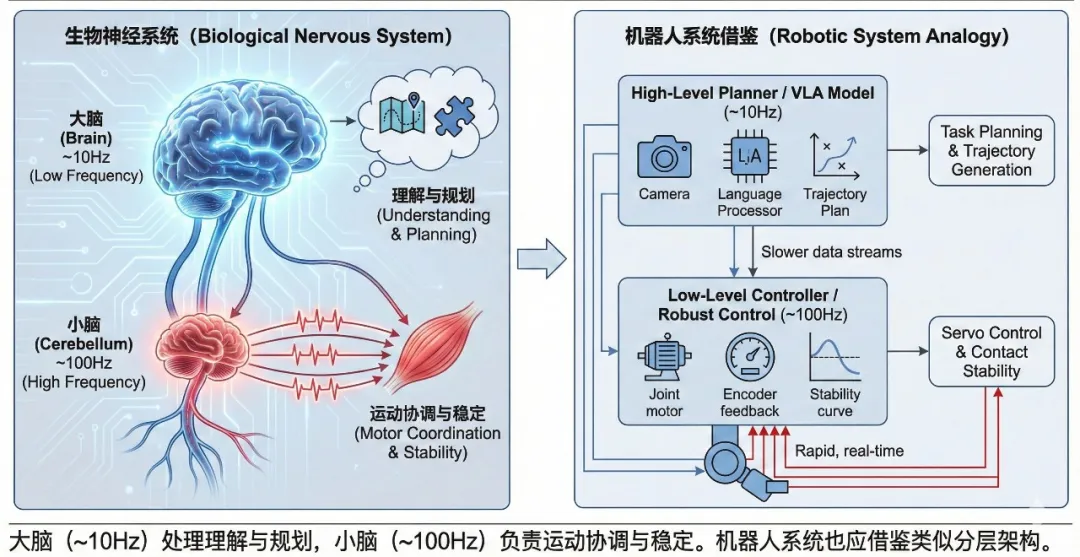

这不是“算力再大一点”就能解决的矛盾,它更像生物系统的分工:大脑低频做理解与规划;小脑高频做稳定与反射。

这也是我认为特别有必要借鉴 AI 在编程领域的实践经验。

AI 编程发展迅猛,模型并未强大到可以精准处理所有代码问题,其上下文长度、推理的概率属性,都会影响整个项目的实施效果。

因此,该领域引入了 MCP / Skills 这类分层范式:AI Agent 负责复杂抽象的逻辑编排与任务交互;工具/技能负责确定、可验证的执行。对错误容忍度低的机器人系统更应该如此。

面对上述这些问题,有些从业者可能会反驳说只要数据足够多了,模型就能掌握足够多的知识和经验,从而解决这些问题。但是,我想说,端到端不是原罪,但把一切押注在 scaling law 上,是一种不够严谨的科学态度。(至少,工程上不够负责。)

4. 物理一致性与前馈线性化

目前的端到端网络试图从数据中重新学习 F=ma 和三角函数。这是极其低效的。经典控制利用反馈线性化或计算力矩法,利用已知的刚体动力学模型抵消非线性项(重力、科氏力),利用几何运动学计算末端刚体运动与驱动关节的关系,使系统对上层呈现为线性。未来的架构应该将已知的物理方程作为归纳偏置嵌入到网络中。

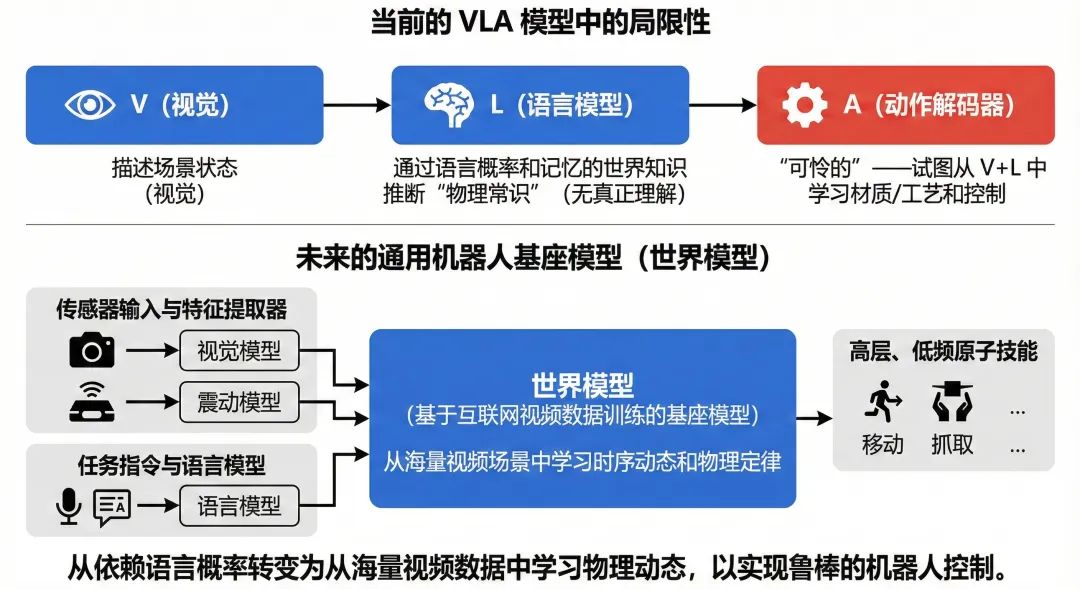

世界模型:互联网视频可能是“数据基座”

当前的 VLA 模型中的 VL 部分并未真正编码/理解“物理规律”,从直觉上看,更多是利用视觉(V)“说明”当前场景的状态,然后期望通过语言模型(V)中“记忆”的语言概率来推理物理规律,认为语言已经编码了“世界知识”。而对于被操作物体材质、任务工艺等具体的物理属性,期望通过结合视觉特征与语言知识,利用可怜的“动作解码器”(A)去学习这些特征,以及对应的控制策略。

当然,实际上模型并不是泾渭分明地划分几个模块,实际上是一个完整的网络,直觉概念上根据其“来源”与“功能”进行了大致的划分。

对此,我有一个强烈直觉:

真正大规模的机器人基座模型的数据,很可能来自互联网真实视频,而不是机器人真机数据。

因为互联网视频覆盖了巨量场景与动力学现象,能学到丰富的“时序世界”。这部分数据有可能让模型“学习”到物理世界的系统动力学关系。

从这个角度看,未来通用机器人大脑的基座模型可能是以互联网视频数据训练的世界模型;输入端是用于估计世界模型状态的各种传感器信息及其特征提取网络(如图像输入与视觉模型、力传感器输入与震动编码模型)、加上用于描述任务的指令与语言模型;输出是更高层次、低频的机器人通用原子能力(如移动、抓取)。

强化学习:它很正确,但“数据来源”是个问题

在有了对世界知识的理解,并通过合适传感器布置确保系统可观性后,通用机器人的普及还存在一个难题,那就是控制策略的生成。像 VLA 一样交给可训练的策略头,利用监督学习/模仿学习,确实可以很快学到基础策略;但是,要想让机器人持续学习,能够应对数据之外的场景,那么强化学习是必经之路。

之前在阅读 Sutton 强化学习教材时,就有非常强烈的“直觉”:人类就是这样学习的,这是对的。后来,在 AlphaGo、DeepSeek、人形机器人控制等多个领域得到了验证。

但如果机器人要从“会动”走向“会干活”,麻烦才刚开始。强化学习很强,但“如何在真实世界持续学习同时保证安全”,依旧是硬骨头。

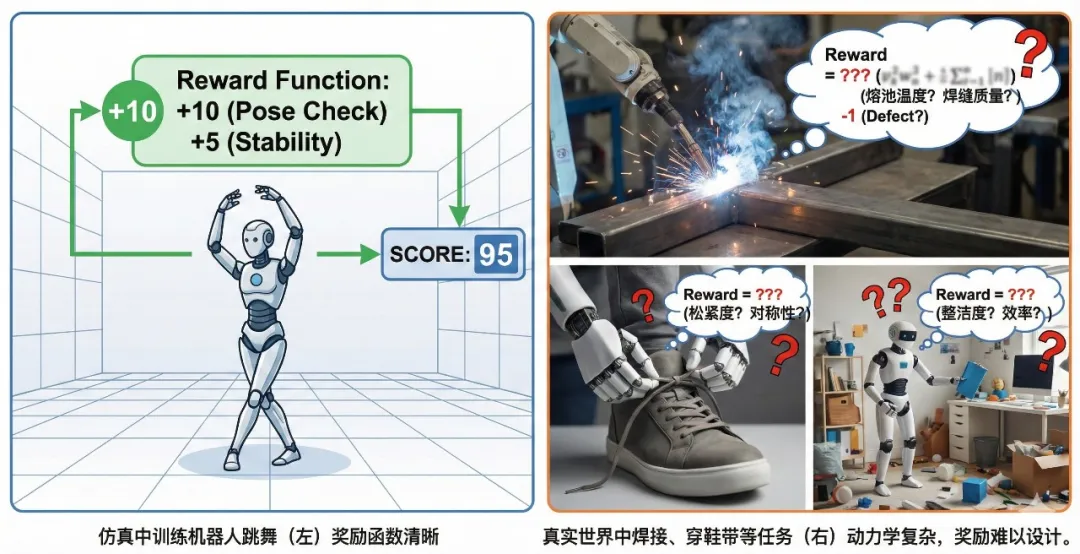

1. 跳舞的奖励函数,比焊接/穿鞋带/收拾房间容易太多

在运动控制里,系统的动力学相对简单(主要是机器人自身动力学,以及其与地面的接触力),奖励函数相对清晰(速度、能耗、摔倒惩罚、模仿人类动作),可以在仿真环境中进行相对准确的仿真、迭代。

但是,在操作任务里,系统的动力学模型与奖励函数都异常复杂或者不明显:焊接熔池在不同电压、材质条件下的的微妙变化不同材质鞋带的形变房间中随机出现物体的物理特性无法预知(如桌上放置的水杯,可能实际上是一个与桌子固定在一起的装饰品)。

你很难通过“仿真”来精准模拟这些动力学系统,也难以靠一个统一 reward 把它们写得又对又可优化。

2. 真机 RL 的核心矛盾:探索 vs 安全

当然,既然仿真不好模拟,是否可以通过在实际环境中探索获得数据?RL 需要探索,但真实世界不允许你随便探索。

这不是一句“加安全员”、“加急停”、“加远程接管”就能糊弄过去的问题。工程上更靠谱的路径,往往是:

让 RL 只学“上限”,把“底线”交给确定性控制(阻抗、鲁棒控制、约束/屏障函数、回退策略)

让学习发生在可控的范围:限定动作空间、限定接触模式、限定能量注入

让系统具备可追踪、可验证的全生命周期机制(数据标定、版本回退、测试验证)

未来的路:从“替代”走向“融合”

批评不是为了否定,而是为了寻找更优解。

如果你让我用一句话总结我目前的判断,那就是:

未来的突破点,不是让 AI 从零开始重新学习 (F=ma),而是把物理定律当作归纳经验嵌进模型的训练规则或结构里;或者把网络当作模块嵌进控制闭环里。

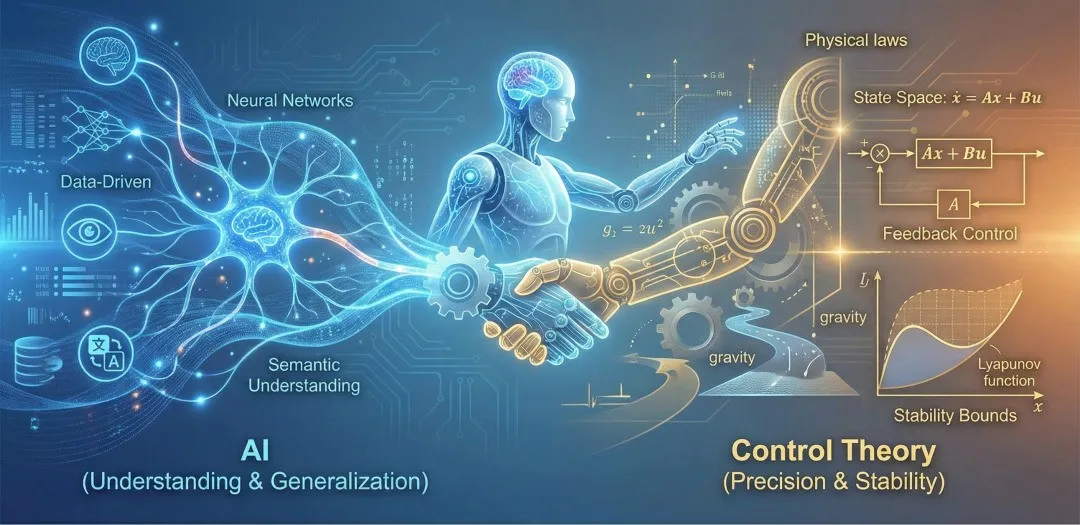

既然 AI 在语义理解和泛化上无与伦比,而控制理论在精确性和稳定性上不可替代,未来的方向不应该是谁取代谁,而是“AI + Control”的深度融合。

1. 分层架构:大脑与小脑的完美分工

未来的智能系统应采用类似于生物神经系统的分层结构:

大脑(VLA/世界模型):运行在低频(1-10Hz)。负责处理多模态感知、长时程规划、语义理解和处理新颖情况。其输出不是关节角度/力矩,而是参考轨迹和动作策略。

小脑(经典控制/鲁棒控制):运行在高频(1kHz+)。负责伺服控制、接触稳定、重力补偿和干扰抑制。无论上层指令如何跳变,底层的物理交互始终是安全和柔顺的。

数据驱动的动力学模型:针对机器人操作中的一些不可建模的动力学系统,通过数据驱动的方式来学习一个能够近似模拟任务动力学的小模型,结合传统控制算法(如 MPC),实现更加鲁棒的小脑控制效果。

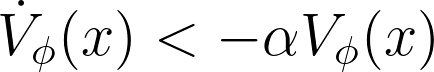

2. 神经李雅普诺夫控制:为 AI 戴上镣铐

为了解决安全性和可信度问题,研究重心将转向可验证的 AI 。

在训练学习策略的同时,训练一个神经网络来逼近李雅普诺夫函数。

在策略更新时,增加约束条件:

这样训练出的策略不仅能完成任务,还能在数学上提供稳定区域的估计,告诉我们在什么范围内机器人是绝对安全的。

3. 在线系统辨识与自适应控制

VLA 模型需要具备上下文学习的能力,这在控制视角下就是自适应控制。当机器人抓起一个未知物体时,VLA 应根据前几帧的预测误差,实时更新潜在状态中的“质量”向量,并瞬间调整控制策略。用 AI 拟合小物理模型/工艺模型,通过在线评估,学习熔池变化、布料材质、表面光滑度等,与 MPC 等确定性技术结合。

结语

机器人是未来,但这个未来不应该建立在沙堆之上。我们需要用控制理论的严谨去约束 AI 的想象力,同时用 AI 的泛化能力去拓展控制理论的边界。

让大模型去理解世界,让控制理论去丈量世界。这种深度的融合,或许才是通往通用机器人的必经之路。