英伟达重磅研究:机器人学会“想象”物理世界了

2026-02-14 21:25:15 · chineseheadlinenews.com · 来源: DeepTech深科技

在走向通用人工智能的道路上,机器人领域长期面临着“莫拉维克悖论”的限制:许多对人类来说很困难的事,AI 却很擅长;而许多对人类来说轻而易举的事,AI 反而做不到。

例如,让计算机在智力测试或棋类游戏中击败人类或许相对容易,但要让机器人像一岁孩子那样具备对物理世界的感知和运动本能,却难如登天。

近年来,大语言模型展现了对人类知识的压缩与生成能力,但在物理交互层面,如何让智能体理解“动作”与“环境”之间复杂的因果关系,始终是具身智能尚未攻克的难题。

近日,英伟达(NVIDIA)与其通用具身智能研究团队(GEAR)共 30 个作者联合发布了一项代号为 DreamDojo 的最新研究成果,试图从根本上影响机器人学习物理世界的方式。

图 | 团队论文:DreamDojo:基于大规模人类视频的通用机器人世界模型(来源:GitHub)

这项工作并没有依赖传统的、昂贵的机器人遥操作数据堆叠,而是另辟蹊径,构建了一个包含 44,000 小时、第一人称视角人类视频的庞大数据库,并以此训练出了一个能够通用化的机器人世界模型。

这一模型不仅能够逼真地生成物理交互视频,更关键的是,它让机器人首次具备了可控的“想象力”。即在执行动作之前,在潜意识中预演人类世界物理后果的能力。

(来源:论文)

世界模型的概念已经并不新鲜。从早期的游戏环境模拟到自动驾驶中的轨迹预测,预测未来状态一直是智能决策的核心。然而,在开放世界的机器人操作任务中,世界模型的构建面临着独特的挑战。与有着清晰规则的电子游戏或结构化道路不同,家庭、工厂或办公室等非结构化环境充满了不确定性。

例如一个看似简单的“抓取水杯”动作,涉及物体材质、摩擦力、液体晃动以及机械臂动力学等无数变量。此前的视频生成模型,如 OpenAI 的 Sora 或 Google 的 Genie,虽然在画面生成质量上取得了突破,但它们大多缺乏精确的动作控制接口,难以直接服务于机器人的决策回路。

而此次 DreamDojo 的核心突破就在于此,它证明了通过大规模的人类视频预训练,结合创新的“潜在动作”(Latent Actions)表征,可以有效地弥合人类与机器人之间的“具身差异”(Embodiment Gap),从而让机器人获得对物理规律的通用理解。

借力人类视频突破数据缺口

长期以来,制约机器人基础模型发展的最大瓶颈在于数据。尽管互联网上充斥着万亿级别的文本和图像数据,但高质量的“机器人操作数据”。即包含精确动作指令(Action Labels)和环境反馈的序列数据却极度稀缺。目前主流的机器人数据集,如 Open X-Embodiment,虽然汇集了多个实验室的数据,但在场景多样性和物理交互的丰富度上,仍远不足以覆盖真实世界的复杂性。

英伟达团队意识到,单纯依靠扩大机器人实体数据的采集规模是不现实的。采集成本高昂、硬件损耗大、场景布置繁琐,这些因素限制了数据的增长速度。相比之下,人类在日常生活中每时每刻都在与物理世界交互,而这些交互过程如果被记录下来,本身就是蕴含着丰富物理知识的宝库。

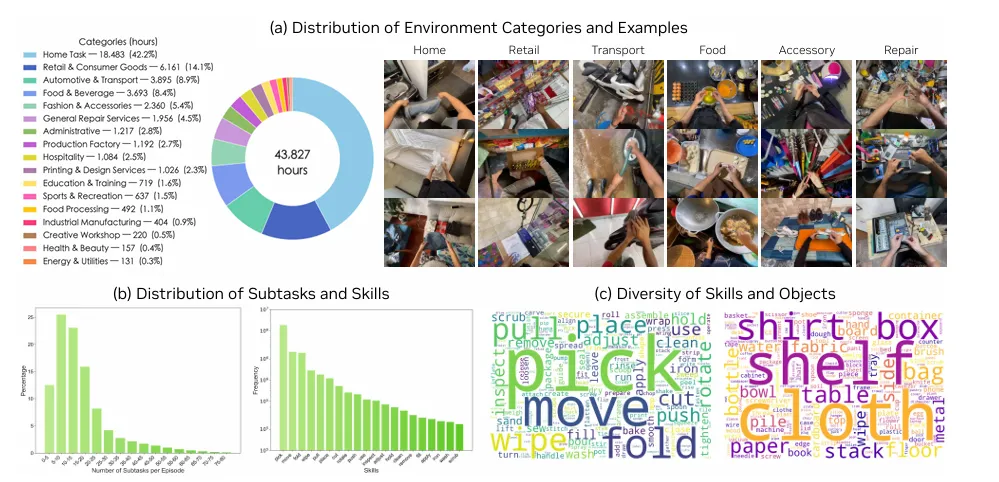

为了挖掘这一宝库,研究团队构建了名为 DreamDojo-HV(Human Videos)的数据集。这是一个规模惊人的数据集合,包含了约 44,711 小时的第一人称视角视频。

这些视频并非来自于受控的实验室环境,而是广泛采集自真实世界,涵盖了家庭烹饪、工业维修、手工制作、日常清洁等超过 6,000 种独特的技能和 1,000 多种不同的场景。为了保证数据的多样性,团队还特别整合了 EgoDex 等现有的高质量数据集,使得 DreamDojo-HV 在规模上比此前机器人学习中使用的最大视频数据集还要大出几个数量级。

图 | DreamDojo-HV(Human Videos)的场景分布(来源:论文)

然而,直接使用人类视频训练机器人模型也面临着一定困难。最直观的问题是:人类的手臂结构与机器人的机械臂完全不同,且人类视频中并不包含机器人的关节角度、力矩等控制信号。这种缺失导致模型难以直接学习“动作”与“结果”之间的映射关系。

逐帧推理下一个动作

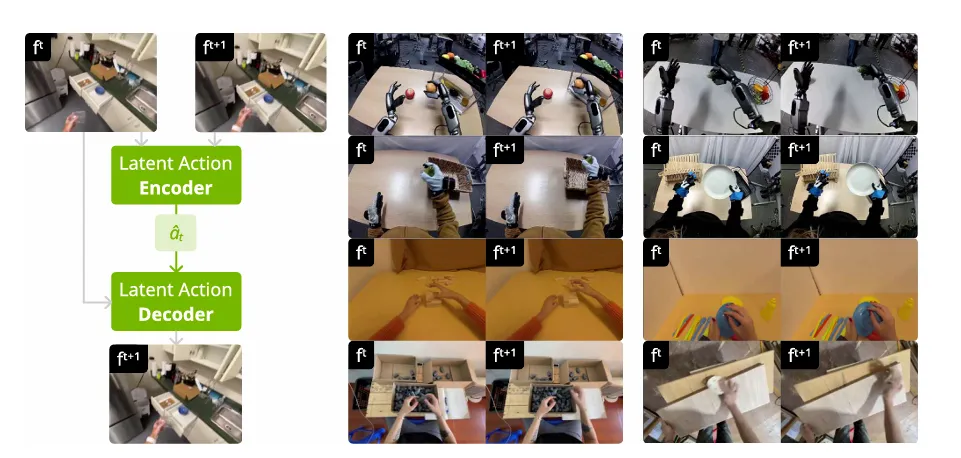

为了解决无标签人类视频的利用问题,DreamDojo 引入了一项关键技术:连续潜在动作(Continuous Latent Actions)。

在传统的机器人学习中,模型通常直接预测离散的关节动作或末端执行器位姿。但在处理海量无标注的人类视频时,这种方法行不通了。因此,研究人员设计了一个基于时空 Transformer 的变分自编码器(VAE)作为“潜在动作模型”。

这个模型的作用类似于一个能够理解动作本质的“翻译官”。它不关注具体的关节如何旋转,而是通过观察视频中连续帧的变化,提取出一个低维的、连续的潜在向量。这个向量代表了导致环境发生变化的“意图”或“力学特征”。

图 | 潜在动作模型(来源:论文)

通过这种设计,潜在动作成为了连接人类视频与机器人控制的通用桥梁。在预训练阶段,模型通过自我监督的方式,学习如何从像素变化中推断出潜在动作,并利用这些潜在动作预测下一帧画面。

这使得 DreamDojo 能够在没有显式动作标签的情况下,从 44,000 小时的视频中汲取物理世界的因果逻辑。例如,它通过观察无数次“手推开门”的视频,学会了“施加推力”这一潜在动作会导致“门打开”这一视觉结果的物理规律,而这种规律对于机器人来说同样适用。

在具体的模型架构上,DreamDojo 建立在英伟达此前发布的 Cosmos-Predict2.5 基础之上。这是一个强大的潜在视频扩散模型(Latent Video Diffusion Model),原本用于通用的视频生成。为了适应机器人的实时控制需求,研究团队对其进行了深度的改造。

为了提高动作的可控性,团队放弃了绝对关节位置的输入方式,转而采用“相对动作”(Relative Actions)作为条件。实验表明,相对动作能够更好地聚焦于物体与手部的交互变化,减少了背景环境对模型注意力的分散。

同时,针对视频生成中常见的“因果混淆”问题,即模型难以区分动作是原因还是结果。研究团队提出了一种“分块注入”(Chunked Injection)策略。

他们将未来的动作序列打包成块,一次性输入到模型的每一帧生成过程中。这种强先验信息强制模型关注长时程的动作影响,从而显著提升了生成视频的逻辑连贯性。

此外,为了确保生成的物理过程符合现实世界的连续性,研究团队还引入了专门的时间一致性损失函数(Temporal Consistency Loss)。这一函数约束了物体在时间轴上的运动轨迹,防止了视频生成中常见的物体闪烁、凭空消失或形状突变等伪影现象,确保了物理模拟的高保真度。

从慢速扩散到超快实时“想象”

拥有一个懂物理的模型只是第一步,对于机器人应用来说,推理速度至关重要。传统的视频扩散模型生成一帧斑质量画面往往需要数十次迭代,耗时数秒,这对于需要毫秒级响应的机器人控制回路来说是不可接受的。

为了解决这一难题,DreamDojo 采用了一种名为“自强迫”(Self Forcing)的蒸馏技术,成功将原本笨重的双向注意力扩散模型转化为高效的自回归模型。

这一过程通过“教师-学生”训练模式实现:首先利用高精度的教师模型生成大量的轨迹数据,然后训练学生模型去模仿这些轨迹。但在蒸馏过程中,学生模型不仅要学习单帧的生成,还要学习如何在仅有极短历史上下文的情况下,预测未来的长期演变。

这一蒸馏过程将模型的推理步数从原本的 35 步大幅压缩至 4 步。最终,DreamDojo 在单张 NVIDIA H100 GPU 上实现了 10.81 FPS(帧/秒)的实时推理速度。这意味着机器人可以在不到 0.1 秒的时间内,在“脑海”中生成未来的视觉反馈。

这不仅满足了实时控制的要求,更让长时程的交互模拟成为可能。实验显示,经过蒸馏后的模型能够连续生成长达 1 分钟(约 600 帧)的稳定视频,且在长时间跨度下依然保持对物体及其物理属性的记忆,没有出现常见的画面崩坏。

打通“虚实”边界的实际应用

DreamDojo 的价值远不止于生成逼真的视频,其实质是为机器人提供了一个低成本、高保真的“试错空间”。基于这一世界模型,英伟达团队展示了三项核心应用,充分证明了其在机器人研发与部署流程中的潜力。

首先是策略评估(Policy Evaluation)。在机器人开发中,验证一个新的控制策略通常需要实机测试,这不仅效率低下,还伴随着硬件损坏的风险。DreamDojo 提供了一个替代方案:将策略部署在世界模型中,让机器人在虚拟的视频流中执行任务。

研究人员在 AgiBot 机器人的水果包装任务中进行了验证,结果令人振奋:DreamDojo 模拟出的任务成功率与真实世界的成功率呈现出极高的线性相关性(Pearson 相关系数高达 0.995)。这意味着开发者可以放心地在模拟环境中筛选最优策略,而无需在现实世界中进行成百上千次的物理实验。

其次是基于模型的规划(Model-based Planning)。利用 DreamDojo 的预测能力,机器人可以在执行动作之前,在“思维”中并行推演多种动作方案的结果。

例如,在抓取一个被遮挡的苹果时,机器人可以预演直接抓取和先移开遮挡物两种方案,DreamDojo 会即时生成相应的未来视频。通过评估视频中的任务完成度,机器人可以选择最优路径。实验表明,在引入这种在线规划机制后,机器人在复杂长程任务中的成功率相比直接执行策略提升了近两倍。

最后是实时遥操作(Live Teleoperation)。借助蒸馏后的高推理速度,操作员可以通过 VR 手柄实时驱动虚拟环境中的机器人。DreamDojo 能够即时响应操作员的动作,并生成相应的视觉反馈。这种“所见即所得”的零延迟体验,不仅为远程控制提供了新的界面,也为人类向机器人演示复杂技能提供了更直观的数据收集方式。

图 | 实时遥操作:可以使用 PICO VR 控制器实时遥操作虚拟 G1 机器人(来源:论文)

当然,DreamDojo 并非完美无缺。英伟达团队在报告中坦诚地指出了当前模型的局限性。尽管在大部分日常场景中表现优异,但在面对一些极端动态(如快速挥手、物体高速碰撞)或涉及复杂流体动力学(如倒水时的水流湍流)的场景时,生成的视频仍会出现物理失真或模糊。

此外,虽然模型在未见过的物体上展现了良好的泛化性,但对于完全陌生的物理机制(例如具有特殊弹性的软体材料),其预测能力依然有限。

此外,目前的 DreamDojo 主要侧重于视觉层面的物理模拟,尚未整合触觉、听觉等多模态信息。对于像“盲插钥匙”或“判断物体重量”这样极度依赖触觉反馈的精细操作任务,单纯依靠视觉预测的世界模型仍显得力不从心。未来的研究方向可能需要探索如何将触觉信号引入潜在动作空间,构建更加全能的多模态世界模型。